数据科学是一门以“数据”,尤其是“大数据”为研究对象,并以数据统计、机器学习、数据可视化等为理论基础,主要研究数据预处理、数据管理、数据计算、数据产品开发等活动的交叉性学科。首先,建立大数据思维方式,学习怎样利用数据;其次,应该了解数据清理、集成、探索等相关技术;最后,洞见和商业意识也至关重要。图1-3数据科学的基本流程......

2023-11-08

1.HDFS简介

HDFS(Hadoop Distributed FileSystem,简称HDFS)是Hadoop架构下的分布式文件系统。

HDFS是Hadoop的一个核心模块,负责分布式存储和管理数据,具有高容错性、高吞吐量等优点,并提供了多种访问模式。HDFS能做到对上层用户的绝对透明,使用者不需要了解内部结构就能得到HDFS提供的服务。并且,HDFS提供了一系列的API,可以让开发者和研究人员快速编写基于HDFS的应用。

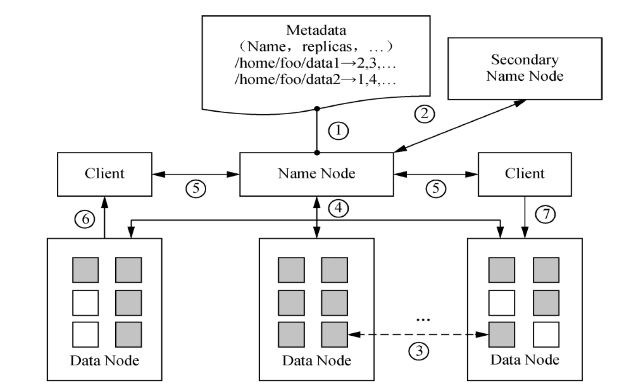

Metadata是元数据,元数据信息包括名称空间、文件到文件块的映射、文件块到DataNode的映射三部分。

NameNode是HDFS系统中的管理者,负责管理文件系统的命名空间,维护文件系统的文件树及所有的文件和目录的元数据。

Secondary NameNode的作用是以备NameNode发生故障时进行数据恢复。

DataNode是HDFS文件系统中保存数据的节点。

Client是客户端,HDFS是文件系统的使用者。

块是HDFS中的存储单位,默认为64MB。

2.HDFS的特点

高效硬件响应,HDFS可能由成百上千的服务器所构成,每个服务器上都存储着文件系统的部分数据。错误检测和快速、自动恢复是HDFS的重要特点。流式数据访问,运行在HDFS上的应用和普通的应用不同,需要流式访问它们的数据集。大规模数据集,运行在HDFS上的应用具有很大的数据集。简单一致性模型,HDFS应用采用“一次写入多次读取”的文件访问模型。异构软硬件平台间的可移植性,HDFS在设计的时候就考虑到平台的可移植性,这种特性方便了HDFS作为大规模数据应用平台的推广。

3.HDFS的体系结构

HDFS采用了主从结构构建,NameNode为Master(主),其他DataNode为Slave(从)。HDFS的体系结构如图5-7所示。

图5-7 HDFS的体系结构

4.HDFS的相关技术

文件命名空间,HDFS使用的系统结构是传统的层次结构。但是,在做好相应的配置后,对于上层应用来说,就几乎可以当成普通文件系统来看待,忽略HDFS的底层实现。

权限管理,HDFS支持文件权限控制,但是目前的支持相对不足。HDFS采用了Unix权限码的模式来表示权限,每个文件或目录都关联着一个所有者用户和用户组以及对应的权限码rwx。

元数据管理。Name Node是HDFS的元数据计算机,在其内存中保存着整个分布式文件系统的两类元数据:文件系统的命名空间,即系统目录树;数据块副本与DataNode的映射,即副本的位置。

单点故障问题。一旦NameNode失效,将导致整个HDFS集群无法正常工作。Secondary NameNode可以部分解决这个问题。除了Secondary NameNode,其他相对成熟的解决方案还有Backup Node方案、DRDB方案、AvatarNode方案。

数据副本。HDFS是用来为大数据提供可靠存储的,这些应用所处理的数据一般保存在大文件中。HDFS存储文件时,会将文件分成若干个块,每个块又会按照文件的副本因子进行备份。

通信协议。HDFS是应用层的分布式文件系统,节点之间的通信协议都是建立在TCP/IP协议之上的。HDFS有三个重要的通信协议:Client Protocol、Client Data Node Protocol和Data Node Protocol。

容错。HDFS的设计目标之一是具有高容错性。集群中的故障主要有三类:Node Server故障、网络故障和脏数据问题。

Hadoop Metrics插件。Hadoop Metrics插件是基于JMX(Java Management Extensions,即Java管理扩展)实现的一个统计集群运行数据的工具,能让用户在不重启集群的情况下重新进行配置。

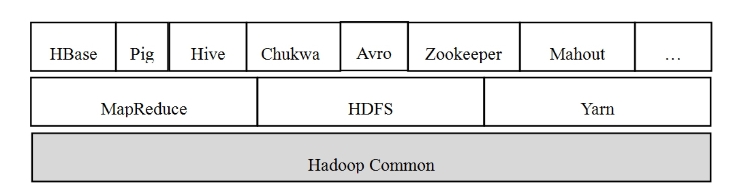

5.Common简介(www.chuimin.cn)

Common在Hadoop架构中的位置。从Hadoop 2.0版本开始,Hadoop Core模块更名为Common。Common为Hadoop的其他模块提供了一系列文件系统和通用文件包。Common为在通用硬件上搭建云计算环境提供基本服务,同时为软件开发提供了API。Hadoop Common如图5-8所示。

图5-8 Hadoop Common

6.HDFS的常用命令

$bin/hdfs显示帮助

$bin/hdfs dfs[参数]文件操作,与$bin/Hadoop fs的参数完全一样

$bin/hdfs namenode-format格式化NameNode

$bin/hdfs getconf从配置文件中获取配置信息

$bin/hdfs fsck[路径][参数]处理损坏的文件

-list-corruptfileblocks输出损坏的文件及丢失的块

-move将文件移动到/lost+found目录

-delete删除损坏的文件

-openforwrite输出以写方式打开的文件

-files输出该目录及子目录下所有文件的状态

-files-blocks输出该目录及子目录下所有文件的块信息

-files-blocks-locations输出该目录及子目录下所有文件在DataNode的存储信息

-files-blocks-racks输出该目录及子目录下所有文件机架感知信息

$bin/hdfs dfsadmin-report查看HDFS的基本统计信息

$bin/hdfs dfsadmin-safemode〈enter|leave|get|wait〉配置安全模式

$bin/hdfs dfsadmin-saveNamespace将内存信息保存到磁盘,并重置edits文件

$bin/hdfs dfsadmin-refreshNodes刷新节点和排除文件

$bin/hdfs dfsadmin-setBalancerBandwidth[byte per second]设置负载均衡带宽

$bin/hdfs secondarynamenode[参数]操作SecondaryNameNode

$bin/hdfs balancer平衡集群中DataNode的数据

有关大数据挖掘技术及其在医药领域的应用的文章

数据科学是一门以“数据”,尤其是“大数据”为研究对象,并以数据统计、机器学习、数据可视化等为理论基础,主要研究数据预处理、数据管理、数据计算、数据产品开发等活动的交叉性学科。首先,建立大数据思维方式,学习怎样利用数据;其次,应该了解数据清理、集成、探索等相关技术;最后,洞见和商业意识也至关重要。图1-3数据科学的基本流程......

2023-11-08

医疗数据类型的多样化,包括数值型数据、类别型数据、图像、文字、信号、语音、视频。高科技的医学检查设备每天都会产生数千兆字节数据。数学特征不显著。数据归属权问题、数据安全问题、法律诉讼问题等。图1-6医疗数据可及性医学数据类型及特点主要包括多系统多类型、数据量大、增量迅速、结构复杂。绝大多数的医疗数据是处于归档状态,检索是十分复杂的。缺乏数据标准,导致无法统一。......

2023-11-08

药品安全事件与人们的身体健康密切相关,大众对此关注度高,容易产生消极的非理性情绪。有报告指出,近90%的药品安全舆情事件均未取得令人满意的结果。Hadoop技术的飞速发展,提高了对大量数据进行处理的效率。基于Hadoop的朴素贝叶斯分类。本书通过其构造基于Hadoop的药品安全舆情话题跟踪模型与算法,完成对药品安全舆情信息的跟踪。......

2023-11-08

打开VMware Workstation→点击文件→新建虚拟机。图9-2选择典型(推荐)选择“安装程序光盘映像文件”,选择指定的CentOS系统的.iso文件,点击“下一步〉”。图9-10在CentOS 6中安装VMware Tools重启CentOs 6。图9-11CentOS 6重启输入密码zkpk,登录进系统。图9-12CentOS 6安装完成下面克隆HadoopSlave。图9-14设置克隆虚拟机选项创建完整克隆。图9-16命名虚拟机图9-17正在准备克隆虚拟机图9-18正在克隆虚拟机点击“关闭”按钮后,发现“HadoopSlave”虚拟机已经在左侧的列表栏中。......

2023-11-08

表7-1数据采集按照数据来源划分,大数据的三大主要来源为商业数据、互联网数据与物联网数据。物联网数据的特点主要包括:物联网中的数据量更大,物联网中的数据传输速率更高,物联网中的数据更加多样化,物联网对数据真实性的要求更高。随着物联网技术、智能设备的发展,这种基于传感器的数据采集会越来越多,相应对于其的研究和应用也会越来越重要。......

2023-11-08

表8-2大数据计算模式表8-3大数据分析与挖掘框架大数据分析是指对规模巨大的数据进行分析。大数据分析的基本方法:预测性分析。知识计算是从大数据中首先获得有价值的知识,并对其进行进一步深入的计算和分析的过程,也就是要对数据进行高端的分析。需要从大数据中先抽取出有价值的知识,并把它构建成可支持查询、分析与计算的知识库。大数据分析处理系统简介:批量数据及处理系统。......

2023-11-08

数据挖掘的功能是指数据挖掘通过预测未来趋势及行为,做出前瞻的、基于知识的决策。数据挖掘的任务主要是关联分析、聚类分析、分类、预测、时间序列模式和偏差分析等。关联分析的目的是找出数据库中隐藏的关联网。关联分析发现关联规则,这些规则展示属性值频繁地在给定数据集中一起出现的条件。聚类分析可以建立宏观的概念,发现数据的分布模式以及可能的数据属性之间的相互关系。......

2023-11-08

关联规则是寻找在同一个事件中出现的不同项的相关性。关联分析即利用关联规则进行数据挖掘。关联规则挖掘问题的描述:项目集,设I={i1,i2,…关联规则挖掘的目标,给定一个事务集合T,关联规则挖掘即找出T中所有满足支持度和置信度分别高于一个用户指定的最小支持度和最小置信度的关联规则。......

2023-11-08

相关推荐