为验证本方案的可行性以及观察文献推荐效果,开展以下实证研究。本方案着重讨论面向内容的推荐,而图书或论文的内容在很大程度上由关键元数据决定。表10.2图书数据表10.3论文数据表10.4是结合表10.2中的图书与表10.3中的论文,依据混合关联的设计方案进行关联后并依据表10.1的评分标准所得到的结果,共形成15对关联二元组。按照这种方式,海量的图书和论文二元组将构建成大规模推荐网络图。......

2023-07-24

本方案是基于内容的文献推荐方法,当用户浏览图书馆信息系统,点击感兴趣的文献链接时,系统查找与用户当前所点击的文献特征高相似度的文献,经过排名后实施推荐。

基于内容的文献推荐方法一般包括以下三个步骤[27][28]:

(1)用户兴趣建模,抽取用户感兴趣的文献特征构建用户偏好模型。

(2)文献数据建模,抽取数据库中备选的海量文献的特征建立模型以匹配用户偏好。

(3)产生推荐列表:结合用户偏好从数据库中检索出高相似度的数据,经过排序后推荐。

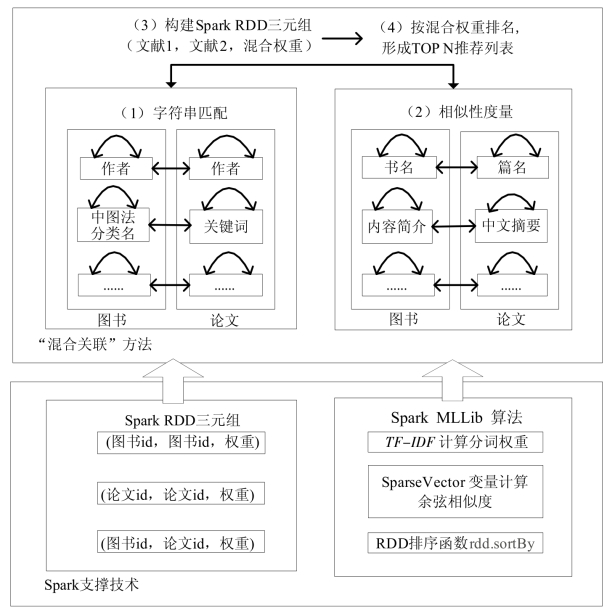

本方案中用户兴趣建模和文献数据建模均采用“混合关联”方案,如图10.13所示。

图10.13 基于Spark的图书馆文献“混合关联”推荐方案

图中(1)到(4)标识了混合关联流程的次序,Spark RDD和Spark MLLib分别是支撑“字符串匹配”和“相似性度量”的关键技术。

1.“混合关联”含义

图10.13方案的推荐对象为图书和论文,推荐的方式有两种:①同类文献推荐,包括“图书到图书”和“论文到论文”的推荐;②非同类文献推荐,包括“图书到论文”和“论文到图书”的交叉推荐。

为优化推荐性能,设计了包括“字符串匹配”和“相似性度量”两种关联方法。“字符串匹配”应用于文献数据库中的简短且规范化的元数据,如“作者”“关键词”等,比较它们在不同的文献中是否相同,从而确定是否关联;“相似性度量”应用于内容较长且表述方式灵活的文档类型的元数据,如“篇名”“中文摘要”等,采用相应算法计算文档相似度,最后整合成混合权重并排名。

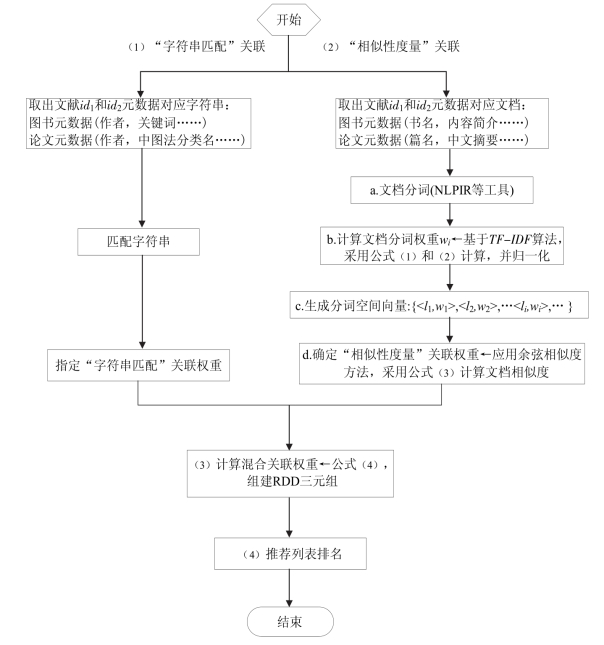

2.“混合关联”及推荐排名算法流程

“混合关联”及推荐列表排名的算法流程如图10.14所示,主要包含4个步骤。

图10.14 “混合关联”及推荐排名实现流程

(1)“字符串匹配”关联。抽取图书数据库中的“作者”和“中图法分类名”,与论文数据库中的“作者”和“关键词”等元数据实现关联。例如,如果某图书和论文的元数据“作者”的值相同(作者的名字相同),就将这两个文献关联成Spark RDD三元组(id1,id2,Wchar),其中id1和id2是文献的id号,Wchar是“字符串匹配”关联的权重,由系统指定,反映该种关联的重要程度。

(2)“相似性度量”关联。抽取图书数据库中的“书名”和“内容简介”,与论文数据库中的“篇名”和“中文摘要”等元数据实现关联。因为相关文档内容较长,所以采用文档相似性度量方法实现关联。主要包含以下步骤:

①文档分词。首先应用分词软件(NLPIR汉语分词系统[29])对元数据文本预处理,将其拆成分词并去掉停用词。

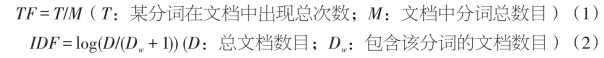

②依据TF-IDF算法[30]分别计算分词的TF和IDF值,相乘得到该分词的TF-IDF值,作为该分词在文档中的权重并归一化。这里TF-IDF是信息检索理论中用于提取文档分词的重要方法。其中词频(TF)是某分词在文档中出现频数,计算方法如公式(1)所示;反文档频率(IDF)用于鉴别某分词是否有良好的区分文档能力,计算方法如公式(2)所示,Dw越小,IDF越大,意味着该分词越重要。

③生成TF-IDF文档向量。将文档内容转换成由分词构成的向量空间模型,{<l1,w1>,<l2,w2>,···<li,wi>,···},式中li为第i个分词,wi=TF×IDF为该分词权重。

④确定文档关联权重。应用公式(3)计算文档D1和D2的余弦相似度Sim(D1,D2),归一化后,作为“相似性度量”阶段的权重WSim,组建RDD三元组,格式为:(id1,id2,WSim)。公式(3)中s为向量空间模型中分词列表长度,wi1、wi2分别为文档D1、D2中对应分词的权重。

Spark库中有专用函数支持“相似性度量”关联的实现。在推荐系统的算法代码中,引入Spark机器学习库MLLib中的函数包TF-IDF,即“import org.apache.spark.mllib.feature.{HashingTF,IDF}”,以支持TF-IDF的计算;引入Spark中的稀疏向量函数包SparseVector,即“import org.apache.spark.mllib.linalg.{Sparse-Vector=>SV}”,实现文档向量的构建和余弦相似度的运算。

(3)计算“混合关联”权重。将文献id1和id2的“字符串匹配”权重和“相似性度量”权重按照公式(4)混合,其计算结果作为两个文献的最终关联权重Whybrid,组建RDD三元组,格式为(id1,id2,Whybrid)。公式(4)中的α是调和参数,取值范围为0≤α≤1,以调节两类关联分别所占的比重;m、n分别为两类关联内部的各自关联次数,例如,如果m、n的取值均为2,表示“字符串匹配”和“相似性度量”各对应两种关联;k是描述关联种类的求和变量。

(4)推荐列表排名。依照Whybrid值从大到小排名,组成TOP N推荐列表。一般引入Spark中的RDD排序函数包,即“import org.apache.spark.rdd.OrderedRDD-Functions”,应用rdd.sortBy()函数排名,将与用户当前访问的文献具有高相关度的文献排在前面。

有关高校图书馆大数据应用模式与实证研究的文章

为验证本方案的可行性以及观察文献推荐效果,开展以下实证研究。本方案着重讨论面向内容的推荐,而图书或论文的内容在很大程度上由关键元数据决定。表10.2图书数据表10.3论文数据表10.4是结合表10.2中的图书与表10.3中的论文,依据混合关联的设计方案进行关联后并依据表10.1的评分标准所得到的结果,共形成15对关联二元组。按照这种方式,海量的图书和论文二元组将构建成大规模推荐网络图。......

2023-07-24

学术界和工业界对知识管理理论进行了深入而广泛的研究,然而迄今为止对知识管理涉及的具体内容及一般过程尚未形成统一认识。这里重点介绍图书情报领域专家的相关表述。其管理过程大致包括知识生产、组织、构建、检索、发现、分享、应用和创新等阶段。在知识经济的背景下,知识的发现、利用和创新是贯穿于高校图书馆各项业务工作的主线,知识管理理论也成为大数据时代图书馆大数据应用和服务的主要支撑理论。......

2023-07-24

图4.3论文数据库和图书数据库本体模型和聚合元数据关联。设有两篇论文的题名分别为:论文A:大数据时代数字图书馆面临的机遇和挑战论文B:大数据时代下图书馆的挑战及其应对策略按以下步骤计算它们的相似程度。......

2023-07-24

国内外专家学者对图书馆电子资源使用统计进行了多角度的研究和应用尝试。国内学者的研究主要集中在应用领域。钟克吟[13]利用ASP技术开发图书馆电子资源读者访问流量统计分析系统来提高数字资源服务效益;王政军[14]提出基于旁路监听技术的图书馆数字资源绩效分析的设计思路和方案,通过记录用户对电子资源的访问下载情况而实施资源访问监控;周欣等[15]提出基于用户日志进行数据采集和数据挖掘的方法,构建用户行为分析系统模型。......

2023-07-24

究其原因,高校图书馆大数据应用正处于起步阶段,数据收集整合、数据分析和知识服务方法有待发展,相关技术有待突破;另外,高校图书馆数据量激增,海量存储的急切需求和计算设备性能的急待提高与资金投入受限也存在尖锐的矛盾。上述因素使得当前高校图书馆大数据应用陷入困境,阻碍了高校图书馆大数据服务的开展。大数据实时处理和高效分析是图书馆知识服务的前提,也是图书馆大数据应用落地的关键。......

2023-07-24

大数据环境下个性化服务的研究引起学界重视。大数据技术的迅速发展以及图书馆个性化服务要求的不断提高,催生了大数据环境下个性化服务的研究,尤其是在关联数据技术与个性化服务结合方面取得了积极进展。以下结合大数据环境下个性化服务特征,讨论用户行为模型的构建策略。......

2023-07-24

Spark框架的软件栈如图2.1所示。Spark SQL是Spark用来操作结构化数据的程序包,支持多种数据源,主要用于查询数据。Spark Streaming的功能是对实时数据进行流式计算,如生产过程中的网页服务器日志或是网络服务中用户提交状态更新的消息队列等,Spark提供了该类操作的API接口,并与Spark Core中的RDD API接口相对应,这使得编程人员能方便操作内存、硬盘数据和实时数据流。......

2023-07-24

图书馆大数据应用必须密切结合图书馆大数据服务的需求,针对性地提出应用模式和解决方案,以促进图书馆大数据服务的真正落地。本书利用语义网这一工具和技术,融合语义网最新研究成果,提出一种基于语义网的学科知识服务模式。因此本书提出面向科研的高校图书馆电子资源使用统计模式。......

2023-07-24

相关推荐