1)调度算法描述把突发数据包划分为不同优先级,同时根据数据包的优先级数把数据信道划分为不同的组。若D3信道在该突发流传输期间到来新的突发包,则使用D4传输或丢弃该突发。图8-26基于突发流的星载光交换信道调度算法突发数据包的丢包率可以通过Erlang B公式得到。原因在于突发流资源预留方式减少了光交换矩阵平均重置时间,从而降低了光突发交换调度的总时延,这也证明了类波长星载调度算法对降低时延有很明显的改善作用。......

2023-07-02

1)基于突发流的星上光突发交换资源预留机制

该算法基于建立的激光链路中继卫星网络场景。考虑到星上资源有限,卫星间相距遥远、卫星处于相对运动中、光接收功率较小、误码率较高且卫星节点数目有限、通信时间受限、星上业务单一、突发性较大,光缓存性能有限且数据连续传输的概率较大、公平性和时延等要求,卫星网络中业务的发送具有较大的突发性和连续性,因此通过借鉴“宏突发”的思想和突发簇的思想,对传统资源预留方式进行了改进。

把突发数据包区分为单个突发和突发流。单个突发就是某些路由相同、QoS要求相同的IP包的数据量只能组装成一个突发包。突发流就是在某段时间内某一业务的数据量较大,能够组装成多个突发包,这些突发包的路由相同且连续发送。卫星光网络中的应用卫星主要是为了获取感兴趣区域或时间的数据,在网络核心节点数不多的情况下(3颗GEO数据中继卫星即可覆盖全球大部分区域)形成突发流的概率较大。

这里通过在BCP中设置标识域来区分单个突发和突发流。设标识域的位数为3位,若标识域最高位为1,则为单个突发;若最高位为0,则为突发流。当核心节点收到BCP时,根据其携带的标识域判定突发类型。若为单个突发,则按照突发长度信息预留资源,并在波长字段写入预留好的波长号,发送完毕后释放资源,整个过程与JET方式完全相同;若为突发流,只确定预留资源的起始时刻,前一个突发传送结束后不释放资源,而是继续传送下一个突发,直到发送完突发流的最后一个突发后释放资源。

OBS网络中资源的状态用呼叫参考标识符(CRI)和入口节点地址共同确定,表明该资源是否被来自某入口节点的某突发(流)所预留,同时在BCP中设置CRI和Source Addr字段来标示某个突发流。

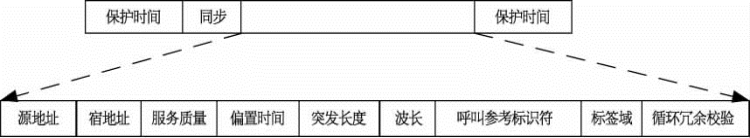

BCP的格式如图8-21所示。定义标识域中:“011”表示突发流中第一个数据突发;“001”表示数据突发处于中间位置;“000”表示数据突发处于宏突发的最后位置;而“1ⅹⅹ”则为单个突发。“波长(wavelength)”字段用来对资源预留成功后的某一核心节点所使用的波长进行记录,目的在于当某些突发包(流)使用的不是本优先级所分配的波长时,在下一个核心节点可以方便变换。BCP中加入呼叫参考标识符CRI表示该突发属于同一个突发流,然后再用标识域表示该突发在突发流中的位置(头、尾或中间突发)。

图8-21 突发控制包的格式

基于突发流进行资源预留的一个特点是每个突发数据包都拥有自己的突发控制包,但是当前面的突发包预留成功后,后续到来的BCP只是进入交换控制单元检测是否是同一突发流中的BDP,若是则直接通过,不必再重复进行预留和光交换矩阵的重置。若前面的突发包预留未成功,则按照本突发控制包中的信息预留资源,后面的突发包依次通过即可。预留成功与否需要在资源列表中有标识。释放资源时通过检测标识域确定是否是最后一个突发包,若是,则发送完成后释放资源。

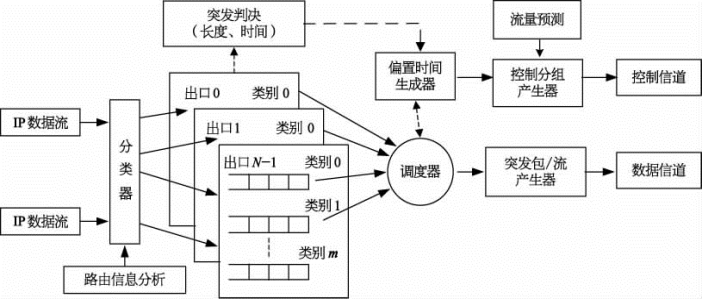

突发流形成的先决条件是当前一个突发汇聚完成时能够预先知道下一个突发的长度,此处可由边缘节点设置一个流量预测器来实现对下一个突发长度的预测,其预测结果通过控制包体现出来。突发流的生成过程如图8-22所示。

2)算法理论模型

(1)吞吐量分析模型。

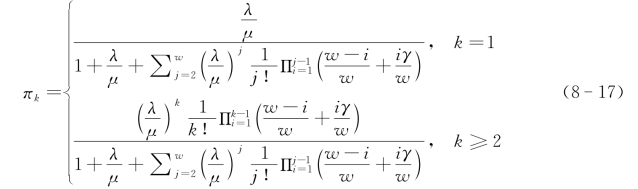

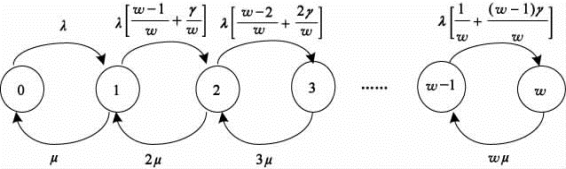

在以上资源预留情况下,定义吞吐量为单位时间内平均发送的突发数。这里研究核心节点的吞吐量。根据研究,假设核心节点具有部分波长转换能力(γ为波长转换率,0<γ=能变换的波长数/总波长数<1),总波长数为W,数据信道波长数为w个,则控制信道波长数为(W-w)个。当数据突发为突发流中的第一个突发包或不属于突发流时,资源预留和调度算法需要为该突发选择数据信道中的某个波长来转发该突发,此时核心节点的资源预留过程可以看作一个M/M/w/w马尔科夫生灭过程。设系统中突发包的到达率为λ,服务速率为μ,则该系统的状态转移图可表示为图8-23。在这种情况下,生的概率bi=![]() 到达率*突发请求获得空闲波长的概率,k为正处

到达率*突发请求获得空闲波长的概率,k为正处 于“忙”状态的波长数。则稳态概率为

于“忙”状态的波长数。则稳态概率为

图8-22 突发流的产生过程

则非突发流吞吐量为

图8-23 卫星光突发交换网络核心节点状态转移

若某突发包在突发流中的序号大于等于2时(标识域中“011”表示突发流中的第一个数据突发;“001”表示数据突发处于中间位置),该突发包不需要等待调度,直接使用资源预留过的波长进行传输就可以了,其吞吐量等于到达率乘以时间。设突发流持续时间为t,则突发流持续期间产生的吞吐量为λt。

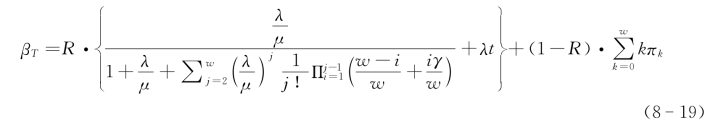

假设突发流在某段时间T中所占平均比例为R,则非突发流所占比例为1-R,则在时间T内产生的吞吐量β T大致可表示为

从式(8-19)可以看出,相比一般的资源预留方法,基于突发流的资源预留方法在一定程度上提高了系统的吞吐量。

(2)时延性能分析模型。

(A)边缘节点平均时延。BDP在输入边缘节点处的平均延时主要由3部分组成,分别是平均组装时间、调度时延、BDP与BCP的平均偏置时间,即T edge=T a+T q+T off,T edge为突发包边缘节点的延时,T a为突发包的组装时间,T q为调度时间,T off为突发包与控制分组的偏置时间。在3种时延中,偏置时延T off用于补偿控制分组在核心节点的处理时间。一般要求T off≥HT oxc+![]() ,其中H为数据突发传送所经历的最大核心节点数,T oxc为核心节点交换矩阵重配置时间,其值由底层硬件设备决定,是一个确定值。ξi为控制分组在第i个核心节点的处理时间,包括控制分组在核心节点的信号处理和排队时间。

,其中H为数据突发传送所经历的最大核心节点数,T oxc为核心节点交换矩阵重配置时间,其值由底层硬件设备决定,是一个确定值。ξi为控制分组在第i个核心节点的处理时间,包括控制分组在核心节点的信号处理和排队时间。

这里组装使用混合门限方法,即不论达到时间门限或长度门限都可以形成突发数据包,是在固定时间门限和长度门限的基础上的一种折中方法。将基于时间门限、基于长度门限和基于混合门限3种组装算法分别简称为FAT算法、FBL算法和FTMMB算法。定义DFAT,DFBL和DFTMMB分别表示3种算法的组装时延。同时设N(t)为[0,t]时间内到达组装器的IP分组个数,τi为一个数据突发包中第i个IP分组的平均时延,n为一个数据突发中包含的IP分组个数。

FTMMB算法可以看作是FAT和FBL算法的结合。设B th为组装长度门限,当组装B th-1个IP分组的时间小于T a时,FTMMB与FBL算法等同;当组装B th-1个IP分组的时间大于T a时,FTMMB与FAT算法等同。若令P为组装B th-1个IP分组的时间大于T a的概率,![]() 为基于时间门限平均组装时延,

为基于时间门限平均组装时延,![]() 为基于长度门限的平均组装时延,混合门限组装算法的平均组装时延为

为基于长度门限的平均组装时延,混合门限组装算法的平均组装时延为

(B)核心节点平均时延。使用混合门限算法对IP数据包进行组装后输出的突发包长度分布可近似于Poisson过程。此处假设K为系统总波长数,k为控制信道波长数,且边缘节点的缓存无限大。

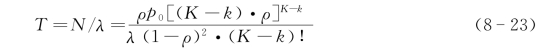

若组装后的BDP是连续的突发流,则除了第一个突发包之外,从第二个突发包开始的后续BDP只需要标识值符合即可,所以其调度时延几乎为0,所以在这种情况下的总的调度时延约等于第一个突发包的调度时延。若突发为单个突发包或突发流的第一个数据包,则会根据突发包的优先级首先依次选择其对应的信道,若对应信道空闲则传送。此时所需的调度时延是LAUC算法的调度时延,假设为t LAUC。根据突发包调度服务时间服从指数分布的规律,这种情况下组装后的调度过程可近似认为是M/M/K-k系统。假设到达调度器的平均突发数为N、突发平均到达率为λ,则平均调度时延为

![]()

式中,P q为BDP到达调度器之后,数据信道暂时没有空闲而必须等待的概率,根据Erlang C公式,P q可表示为

![]()

则把式(8-22)代入式(8-21),可得

对于BDP来说,在核心节点是以“直通”的方式进行交换,在核心节点只有一个光交换过程,所以核心节点的延时T core=T switch。

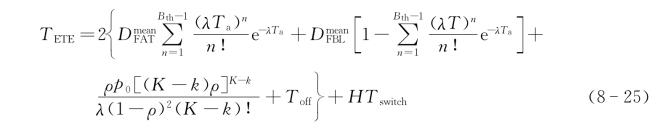

若一个突发包在网络中经过了H个核心节点,2个边缘节点,则平均端到端时延可表示为:T ETE=2T edge+HT core。

所以端-端时延可表示为

![]()

也可写为

式中,T off对某一突发包来说是固定值。

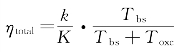

资源预留方式的变化可通过链路利用率体现出来。在考虑保护时间的条件下,星载光交换网络总的链路利用率可以表示为: ·ρi。其中T bs为数据突发传输时间,T oxc为设备倒换时间,ρi为单波长信道的业务量强度,K为总的波长数,k为数据信道数。在其他因素固定的情况下,通过使用突发流的资源预留方式,链路利用率随着设备的倒换时间T oxc(即光交换矩阵的重置时间)的减小而逐渐增大。

·ρi。其中T bs为数据突发传输时间,T oxc为设备倒换时间,ρi为单波长信道的业务量强度,K为总的波长数,k为数据信道数。在其他因素固定的情况下,通过使用突发流的资源预留方式,链路利用率随着设备的倒换时间T oxc(即光交换矩阵的重置时间)的减小而逐渐增大。

3)仿真及分析比较

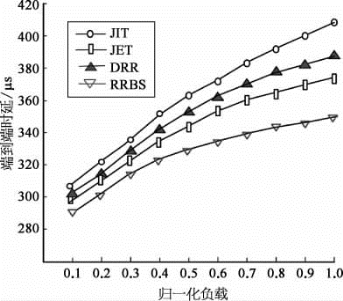

为了考察RRBS的性能,使用该算法进行资源预留仿真,卫星数据要从卫星E1传送给地面站OGS2,并在同样条件下使用JIT,JET,DRR算法进行星上光交换资源预留,并和RRBS进行比较。RRBS资源预留算法调用了LAUC调度算法。

假设突发数据BDP以泊松过程到达,到达率为λ,BDP的长度服从1/μ=0.1μs的指数分布,边缘节点(LEO)组装算法使用混合门限方式,边缘节点使用了基于线性预测滤波器流量预测算法。在相同的条件下使用不同的资源预留方法进行仿真,结果如图8-24所示。从图中可以看出,与JIT,JET,DDR算法比较,RRBS时延最小,JIT协议时延最大,这说明RRBS的性能相比JIT,JET,DRR有了较大的提高。负载为0.5时,RRBS的端到端时延性能相比JET提高了3.44%,比DRR提高了9.38%,比JIT提高了14%。原因在于JIT协议是显示建立和拆除的,中间节点只有收到RELEASE消息时,才将预留的信道资源释放,这也造成了后续数据包等待时间较长,从而导致端-端时延性能不佳的结果。JET和DRR算法都属于估算建立和拆除方式,所以在时延性能上比JIT要好。DRR算法为了形成宏突发在边缘节点处有一定的等待时间,而RRBS没有设置等待时间,所以在突发流较多的情况下它在核心节点的调度时间几乎为0,故它的时延性能更好。

图8-24 不同资源预留协议下的端-端时延比较

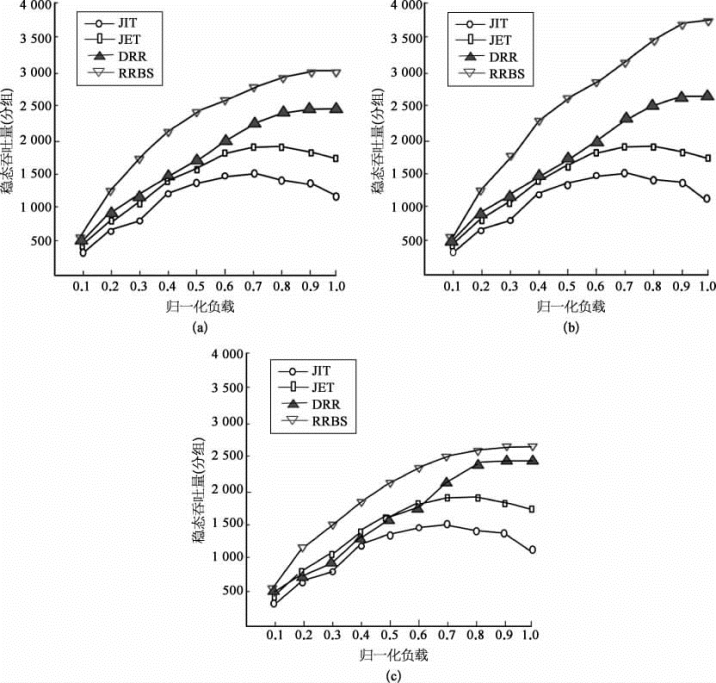

图8-25为稳态吞吐量与负载率在不同突发流比例下的关系图。从图中可以得到,不论突发流在整个负载中的比例为多少,RRBS的吞吐量性能都较其他资源预留协议好很多,性能最差的是JIT,其次是JET,DRR。随着相同目的地址数据包的增多,连续突发流的比例也在增大,这样DRR和RRBS的吞吐量也随之逐渐上升,但是RRBS更为明显,原因在于:①它没有为了形成突发流而设的“人为”延时,而DRR算法有这部分延时,吞吐量受到了一定的影响。②突发流比例越大,在交换矩阵的配置上和调度上得到的“好处”越多,在吞吐量上得到了体现,从而也验证了前面的理论分析。

图8-25 稳态吞吐量比较

(a)R=0.1;(b)R=0.5;(c)R=0.8

有关空间激光微波混合信息网络技术的文章

1)调度算法描述把突发数据包划分为不同优先级,同时根据数据包的优先级数把数据信道划分为不同的组。若D3信道在该突发流传输期间到来新的突发包,则使用D4传输或丢弃该突发。图8-26基于突发流的星载光交换信道调度算法突发数据包的丢包率可以通过Erlang B公式得到。原因在于突发流资源预留方式减少了光交换矩阵平均重置时间,从而降低了光突发交换调度的总时延,这也证明了类波长星载调度算法对降低时延有很明显的改善作用。......

2023-07-02

1)星载光交换组装算法设计时考虑的问题星载光交换组装算法设计时主要考虑的问题有:①业务种类多,QoS要求不一致。图8-15混合组装门限取值范围2)星载光交换组装算法结合卫星光网络的特点,对基于Round-Robin的组装算法进行改进:LEO把来自各个传感器的数据分别按照数据的优先级和目的地址存储到不同的缓存中,每个缓存队列都配置一个组装器,如图8-16所示。假设突发组装长度门限下限为L min,上限为L max,组装时间的门限分别为T min和T max。......

2023-07-02

国防科技大学团队提出了基于报文突发交换技术的星上交换方式,这是一种借鉴光突发交换设计的星上光电混合交换方式。图8-12星上报文突发交换技术采用的MEO/LEO双层卫星网络体系结构利用该方法,研究人员设计了星上PBS交换的网络协议栈结构,在物理层和IP层之间增加了汇聚与分解子层,并从两个方面对星上PBS进行了研究,其协议栈结构如图8-13所示。......

2023-07-02

对于γ-MAHSCP模型,仍属于NP-Hard问题,可采用启发式算法进行模型求解。本书采用分散搜索算法进行求解,分散搜索算法是一种进化算法,依靠类似遗传算法的进化机制,通过迭代向最优解收敛。通过上述分散搜索算法,能够很好地求解γ-MAHSCP模型。该模型得出的结果与γ-SHSCP模型求解不同,因为非枢纽点的分配方式不同,枢纽点的布局也不尽相同。......

2023-09-19

其中有一段孟加拉虎的表演,特别受观众的喜爱。这名驯兽师被迫呆在兽笼里与凶猛的老虎为伍。其实,在复杂多变的生活中,我们也会与“黑暗中的老虎”不期而遇。......

2023-12-02

所以,设γ为绕道系数,指每条经过枢纽站的O-D流所需总时间与两点之间直通时间的比值:。即:rk Xik+αtkm Xik Xjm+tjm Xjm≤γ*tiji,j,k,m∈N在第5章L-SHSCP模型的基础上,构建了带有绕道限制的应急服务设施枢纽单分配集覆盖模型:上述变量和约束条件意义同第4章规定,其中约束条件式(5-8)保证所有O-D流的出行时间必须保证在最大绕道系数之内。......

2023-09-19

由于泥石流、暴雨而形成的堰塞体堵塞河道,致使舟曲长达23天浸泡在洪水和污泥当中,千余名官兵、200余台挖掘机连续作战进行应急排险以及河道的清淤工作,才得以使舟曲县城全面退水[86]。在应对重大突发事件的过程中,应急服务需求的特点主要表现如下。......

2023-09-19

p-中心选址模型是Hakimi[17]提出的,该模型的目标是为p个服务设施进行选址,使得各个需求点到p个服务设施之间的总加权距离最小。这些应急服务设施,应急响应的及时性要求不是很高。在各类突发事件中,应急服务设施选址涉及经济、技术、社会、安全等诸多因素。魏汝营[35]等综合考虑应急设施选址的效率性、公平性和成本等多方面因素,建立了一个多目标决策模型,采用线性加权和法求解该模型。......

2023-09-19

相关推荐