早期的图像分割研究主要集中于对狭义图像分割的研究,且并未区分狭义图像分割与目标分割的概念,界定比较模糊。3)图像仅是现实世界的表象。只有随着各学科的综合发展,目标分割才会不断有新的突破。总之,尽管长期以来人们为研究目标分割问题做出了很大努力,但上述原因导致很难实现一种普适的方法,而只能针对特定问题和具体的需求给出合理的解决方法,在处理速度、精度等关键性指标上做出均衡或侧重。......

2023-06-28

机器视觉必须完成的一个任务是识别。在完成对物体的图像特性采集和提取后,系统必须找到一种方法将其归为一个已知类即赋予该物体一个已知的类别。模式分类领域提供了完成这个任务的算法。

现代网络上图片视频这种计算机图形信息与日俱增,人们期望能对处理后的图像迅速而有准确的归类;因此,与机器学习这一前沿领域结合,为构造大规模的计算机视觉系统提供了可能。

(1)SVM支持向量机

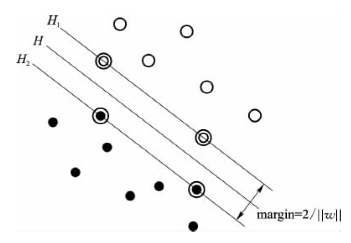

SVM是从线性可分情况下的最优分类面发展而来的,基本思想可用图10-8所示的两维情况说明。图中,实心点和空心点代表两类样本,H为分类线,H1、H2分别为过各类中离分类线最近的样本且平行于分类线的直线,它们之间的距离叫做分类间隔(margin)。所谓最优分类线就是要求分类线不但能将两类正确分开(训练错误率为0),而且使分类间隔最大。分类线方程为wx+b=0,可以对它进行归一化,使得对线性可分的样本集:

图10-8 SVM基本思想

(Xi,Yi),i=1,…,n,x∈Rd,y∈{+1,-1}

满足约束条件:

Yi[(wXi)+b]-1≥0,i=1,…,n

此时分类间隔等于2/‖w‖,使间隔最大等价于使‖w‖/2最小。满足条件约束条件且使‖w‖/2最小的分类面就叫做最优分类面,H1、H2上的训练样本点称为支持向量。

图10-8最大线性可分,于是可以总结出,想要找到样本空间内最大划分平面可以转化为求解以下数学问题:

minw,b‖w‖2/2

Yi[(wXi)+b]-1≥0

这就是支持向量机的基本型。

模式识别方面最突出的应用研究是贝尔实验室对美国邮政手写数字库进行的实,这是一个可识别性较差的数据库,人工识别平均错误率是2.5%,用决策树方法识别错误率是16.2%,两层神经网络中错误率最小的是5.9%,专门针对该特定问题设计的五层神经网络错误率为5.1%(其中利用了大量先验知识),而用三种SVM方法得到的错误率分别为4.0%、4.1%和4.2%,且其中直接采用了16×16的字符点阵作为SVM的输入,并没有进行专门的特征提取。实验一方面说明了SVM方法较传统方法有明显的优势,同时也得到了不同的SVM方法可以得到性能相近的结果(不像神经网络那样依赖于模型的选择)。

(2)K-NN算法

K近邻学习是一种常见的监督学习方法,其工作机制非常简单:给定测试样本,基于某种距离度量找出与其最靠近的k个最靠近的样本,然后基于这k个邻居的信息来进行预测。通常,在分类任务中可使用投票法,即基于这k个样本中出现最多的类别来作为预测的结果。在回归任务使用平均法,即将这k个样本的输出平均值来作为预测的结果。

与一般的机器学习方法,K近邻算法有一个显著的不同之处。它没有显式的训练过程,是懒惰学习的代表,此类算法仅仅是将样本保存起来,训练开销为零,待收到测试样本再进行处理。

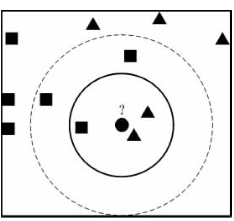

图10-9给出了K近邻分类器的示意图。显然,k是一个重要参数,当k取不同值时,分类器会输出不同结果。另一方面,若是选取不同的距离计算方式,输出的结果也会显著不同。

图10-9中,当k=3时,圆形点被判定为三角形,因为与它最近的3个邻居中有2个是三角形按照投票法,圆形点被预测为三角形;当k=5时,圆形点被算作正方形,与它最近的5个邻居中有3个是正方形。

在性能上最近邻分类器虽然简单,但是泛化错误不超过贝叶斯最优分类器的两倍。

图10-9 k邻近算法的示意图

有关工业智能技术与应用的文章

早期的图像分割研究主要集中于对狭义图像分割的研究,且并未区分狭义图像分割与目标分割的概念,界定比较模糊。3)图像仅是现实世界的表象。只有随着各学科的综合发展,目标分割才会不断有新的突破。总之,尽管长期以来人们为研究目标分割问题做出了很大努力,但上述原因导致很难实现一种普适的方法,而只能针对特定问题和具体的需求给出合理的解决方法,在处理速度、精度等关键性指标上做出均衡或侧重。......

2023-06-28

时间定额与产量定额互为倒数。机械消耗定额以一台机械一个工作班为计量单位,所以又称为机械台班定额。施工定额是以同一性质的施工过程——工序作为编制对象,表示生产产品数量与生产要素消耗综合关系的定额。概算定额是编制扩大初步设计概算、确定建设项目投资额的依据。地区统一定额包括省、自治区、直辖市定额。企业定额是指由施工企业考虑本企业具体情况,参照国家、部门或地区定额的水平制定的定额。......

2023-08-27

为了保证其韧性和塑性,含碳量一般不超过1.7%。由于节省燃料,转钢炉已成为主要钢种。镇静钢化学成分均匀,力学性能较好,但有缩孔,成本高。特殊镇静钢 比镇静钢脱氧程度更充分彻底的钢。特殊镇静钢的质量最好,适用于特别重要的结构工程。表1-1 钢按化学成分分类4.按钢的品质分类普通钢 钢中含杂质元素较多,一般S、P的含量均小于0.07%,如碳素结构钢、低合金高强度钢等。1)Q195:强度低,塑性高,有良好的压力加工性和焊接性。......

2023-06-23

表8-2大数据计算模式表8-3大数据分析与挖掘框架大数据分析是指对规模巨大的数据进行分析。大数据分析的基本方法:预测性分析。知识计算是从大数据中首先获得有价值的知识,并对其进行进一步深入的计算和分析的过程,也就是要对数据进行高端的分析。需要从大数据中先抽取出有价值的知识,并把它构建成可支持查询、分析与计算的知识库。大数据分析处理系统简介:批量数据及处理系统。......

2023-11-08

电子计数器是利用数字电路技术输出给定时间内所通过的脉冲数并显示计数结果的数字化仪器。电子计数器工作原理可以看作被测时频与标准时标进行比较的过程,充分体现了测量的实质。一般我们把具有测频和测周两种以上功能的电子计数器都归类为通用计数器。专用计数器是指专门用于测量某种单一功能的电子计数器。......

2023-06-22

简言之,图像分割就是聚类,将图像中不同的区域进行分类,进而提取目标。图4.1 图像分割方法分类3.图像分割方法分类分割过程中主要有两种处理策略:并行算法和串行算法。 噪声污染图像的某种图像分割算法性能评价分析目的:评价在不同种类、不同强度噪声污染情况下该图像分割算法的性能。......

2023-11-24

而Richard Szeliski也成为了图像拼接领域的奠基人,这套理论已经成为了一个经典理论体系,现在许多人依然在这套理论基础上做进一步研究。因此M.Brown提出的理论大大地推动了图像拼接技术的发展,也将全景图拼接技术研究推向高潮。......

2023-06-28

生物制品是以微生物、细胞、动物或人源组织和体液等为原料,应用传统技术或现代生物技术制成,用于人类疾病的预防、治疗和诊断的医药用品。以上三类制品都是富含免疫原性的抗原,用于预防疾病,又称预防用生物制品。诊断试剂属于诊断用生物制品。......

2023-06-24

相关推荐