关联规则是寻找在同一个事件中出现的不同项的相关性。关联分析即利用关联规则进行数据挖掘。关联规则挖掘问题的描述:项目集,设I={i1,i2,…关联规则挖掘的目标,给定一个事务集合T,关联规则挖掘即找出T中所有满足支持度和置信度分别高于一个用户指定的最小支持度和最小置信度的关联规则。......

2023-11-08

文本挖掘从数据挖掘发展而来,是Ronen Feldman等人最早提出了文本挖掘的相关概念:从海量文本的数据集合中或语料库中发现隐含的、令人比较感兴趣的、有潜在的价值的规律与信息。国内将文本挖掘定义为:文本挖掘是指从文本数据中获取可理解的、可用的知识,同时运用这些知识更好地组织信息以便将来参考的过程。

文本数据是一种主要的非结构化数据,因为它无一定形态,长度可以任意变化,结构又比较复杂,无法用数据库的二维逻辑来表现,因此比较难处理。文本挖掘是指从大量的文本数据中提取出有规律的模式和有趣的知识的过程。文本挖掘是由数据挖掘发展而来,因此两者有交集,也有区别,比如文本挖掘主要处理对象是无固定模式的非结构化数据,而数据挖掘所处理的对象一般以关系型数据库为主。在文本挖掘中,文本预处理过程的质量好坏会直接影响最终的模式的识别与知识的发现,因此预处理过程在文本挖掘中是相当重要的环节。

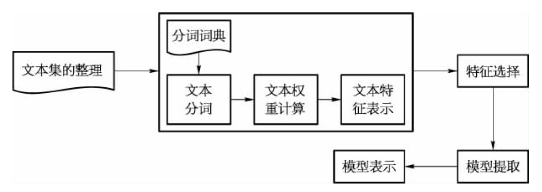

文本挖掘的主要方法包括对文本型数据进行分类、聚类、观点挖掘、情绪分析、关键词自动提取、话题的发现与聚类、语义分析、文档的自动摘要和实体关系模型等。文本挖掘的流程主要包括文本获取(文本源)、数据清洗(预处理)、文本特征选择(表示和抽取)、构建模型、模型评估、知识。

文本挖掘的流程如图9-3所示。

图9-3 文本挖掘流程图

(1)文本获取

处理对象是以文本形式存储的信息,寻找出其中潜在的知识或规律,这是文本挖掘第一步。与结构化数据不同的是,结构化的数据是可以直接从关系数据库中获取的。文本型数据的获取方式有很多种,比如有些文本型数据如Web页面数据需要对其进行处理(去掉其html标签后,进行分句,再进行分词)将其变为结构化的文本数据;又如有些文本数据是已经经过处理后存储在数据库中的数据。

(2)数据清洗

这是文本挖掘中关键的一步。由于文本获取的数据文件并非一般意义上的关系型数据,因此首先需要将该数据文件转换为机器可识别的关系数据,并且能表现文本内容的结构化形式。与结构型数据不同的是文本型数据一般只有有限的结构,或者直接就是非结构化的数据,而且文本型数据对于计算机处理来说本身就是相当困难的。因此文本内容无法用目前的数据挖掘技术直接进行处理,需要对文本进行预处理。由于文本内容包含了大量的文本信息,需要去除大量的噪声,同时要保留每一个文档的特征,并用一定的特征模型作为文本的表示形式,把文本由非结构化数据转化为结构化的数据。

(3)文本特征选择

文本特征指的是关于文本的元数据,分为两种:描述性特征(文本的名称、日期、大小、类型);语义性特征(文本的作者、机构、标题、内容)。通常文本型数据都具有相当大的维度空间,将导致在文本挖掘阶段消耗更多的计算机资源与处理时间。文本处理阶段主要包括:常用的停用词表的过滤与删除,即使用词表来删除那些很不常用又或者副词之类出现频率很高但是信息价值不高的常用词,并根据词语片段在文本结构中位置的不同给予不同权重(比如段首与段尾的权重可能要比段中的权重要高)以及进行同义词的分析(比如360与奇虎就是同义词),还有一词多义的分析(比如苹果有可能说的是我们平常吃的水果,也有可能是美国产的苹果手机的意思)等。文本模型表示后的数据规模一般非常大,通常都具有很高的维数,特别是采用向量空间模型时,文本向量会达到数百万维度甚至更大。如果对于这种维数文本进行处理通常会耗费大量的时间,因此选择最有代表性的特征词从而将文本的特征集进行压缩,以降低文本的维数是相当必要的。

(4)文本处理

文本数据经过特征化处理后进入挖掘阶段。文本挖掘任务主要包括:文本聚类分析、文本关联分析、文本分类分析、信息检索、链接分析等。由于文本型数据通常都是具有比较复杂、维度比较高而且具有语义与语境的特点,所以用传统的文本挖掘算法来进行知识挖掘,常常得不到好的效果,因此进行文本挖掘时需要根据所要分析语料的特点来改进或使用新的算法来进行挖掘。一般来说主要有两个算法选择的影响因素:一是客户挖掘时的具体需求是什么;二是根据不同文本型数据各自具有的特点进行模型算法的选择。文本挖掘过程的核心是文本挖掘的算法,而文本挖掘算法也是目前的主要研究方向,采用合适的文本挖掘算法能提高挖掘效率,而且也能取得比较好的结果。想要得到好的挖掘结果,必须深入理解各种挖掘算法的前提与要求,并根据所需要训练的文本的特点并结合适当算法进行挖掘。

(5)评估——知识发现和模式提取

这是文本挖掘的最后一个环节。通过用户预定义的评估指标体系对文本挖掘所获取的知识进行评价,并根据评价结果抉择是否留用。文本挖掘的结果是面向各种应用的知识模式。利用已经定义好的评估指标对获取的知识或模式进行评价。如果评价结果符合要求,就保存知识或模式以备用户使用;否则返回到前面的某个环节重新调整和改进,然后再进行新一轮的发现。通过评估可以改进文本挖掘的知识发现过程。

有关工业智能技术与应用的文章

关联规则是寻找在同一个事件中出现的不同项的相关性。关联分析即利用关联规则进行数据挖掘。关联规则挖掘问题的描述:项目集,设I={i1,i2,…关联规则挖掘的目标,给定一个事务集合T,关联规则挖掘即找出T中所有满足支持度和置信度分别高于一个用户指定的最小支持度和最小置信度的关联规则。......

2023-11-08

数据剖析,也称为数据概要分析,或者数据探查,是一个检查文件系统或者数据库中数据的过程,由此来收集它们的统计分析信息。数据剖析不仅有助于了解异常和评估数据质量,也能够发现、注册和评估企业元数据[48]。传统的数据剖析主要是针对关系型数据库中的表,而新的数据剖析将会面对非关系型的数据、非结构化的数据以及异构数据的挑战。多源数据的统计信息则包括主题发现、主题聚类、模式匹配、重复值检测和记录链接等[47]。......

2023-06-23

如果数据挖掘系统是交互的,数据挖掘结果的表示和显示这一点便尤为重要。从数据库角度来讲,有效性和可规模性是数据挖掘系统实现的关键问题。以上问题是数据挖掘技术未来发展的主要挑战。......

2023-06-21

图2-8常用药知名老中医马祥治疗胃炎的常用药物药性分析104张处方中出现的药性为平、温、寒、凉、微温、微寒,分析结果显示药性,所使用频率由高到低依次为温,平,微寒,寒,微温(72次),热(42次),凉(10次)。图2-9药性分布知名老中医马祥治疗胃炎的常用药物药味分析104张处方中,药味分布最多的是味苦的药物,药味分析结果以苦味为主,如图2-10所示。......

2023-11-08

在数据处理方面:Flume对数据进行简单处理,并写到各种数据接收方处。为了保证配置数据的一致性,Flume引入了ZooKeeper,用于保存系统配置的数据。同时,在配置数据发生变化时,ZooKeeper可以通知Flume Master节点。Flume Master间使用gossip协议同步数据。Flume-ng取消了集中管理配置的Master和Zookeeper,变为一个纯粹的传输工具。在Flume-og中,读入线程同样做写出工作。如果写出慢的话,它将阻塞Flume接收数据的能力。......

2023-11-08

网络信息的知识发现是从网络信息中提取人们感兴趣的知识,这些知识可能是隐含的、事先未知的、潜在有用的信息,它集数据收集、数据清理、维数变换、规则归纳、模式识别、数据结果分析及评估等多种过程于一身,是统计学、计算机科学、模式识别、人工智能、机器学习及其他学科相结合的产物。数据挖掘方法分为统计方法、机器学习方法、神经网络方法和数据库方法。......

2023-07-02

常用的数据挖掘方法有四大类,分别对应四个问题,这四个问题是数据挖掘的基础,分别是聚类挖掘、分类挖掘、关联模式挖掘和异常值检测。1)K最近邻分类算法K最近邻分类算法可以说是整个数据挖掘分类技术中最简单的方法。目前,数据挖掘领域有大量的聚类算法。......

2023-06-21

数据清理是指填充缺失值,光滑噪声并识别离群点,纠正数据中的不一致。主要针对缺失值数量较少且删除数据对整体数据几乎没有影响的数据进行处理,也可以根据数据缺失挖掘信息。......

2023-11-08

相关推荐