目前有些地方还无法实现FTTH 的一步到位,这种情况下,交互式数字视频是一种较好的综合解决方案。如图11.20所示,主干系统采用共缆分纤的方式分别由FTTC传送双向数字信号,由HFC 传送单向模拟视频信号。图11.20SDV 结构原理图这种解决方案的优点是:可以充分利用现有HFC 有线电视网络,共享光缆、管孔等基础设施,兼容数字和模拟视频业务,并较好地解决FTTC 的供电问题。......

2023-06-26

针对客户问句与客服回答之间的匹配问题,本案例分别构建了基于CNN的语义匹配模型和基于RNN的生成模型,模型的输入层是句子的词向量矩阵,输出层是问答匹配的置信度。分别在Semeval-2016社区问答数据和在线客服对话数据上进行了不同模型的性能对比。同时对问句的完整性、生成模型的不同结构、阈值选择以及客服数据的抽取方式等进行了对比实验分析。

基于数据统计分析,根据电商客服对话数据的特点,我们选择了由Mikolov等人提出的词嵌入的方式,将词表征为低维稠密的实数值向量。针对词向量的训练,这里我们选择了连续词袋模型(continuos bag of words,CBOW)作为训练词向量的模型。词向量的训练不需要人工标注的有监督数据,因此可以尽量扩充与实验数据相关的词向量训练语聊,获取语义信息表达更丰富的词向量。这里我们主要选择了wiki英文语料、电商客服对话数据语料和百度知道问答通用语料。Wiki英文语料和百度知道语料的规模比较大,达到了十多GB,电商客服的数据相对比较少。

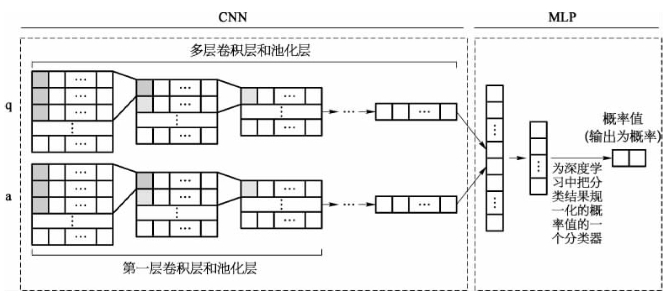

本案例在使用基于CNN的匹配模型时,将问题或者答案的选择人物当做句子对间的语义匹配关系分类任务进行模型的构建,模型如图7-7所示。图中,q表示问句,a表示答句。

图7-7 基于CNN的问答匹配关系识别模型结构图

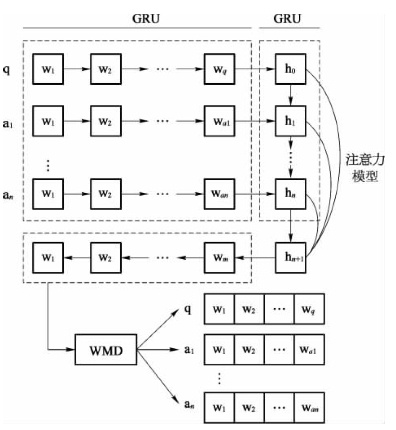

图7-8 基于RNN的问答匹配关系识别模型

与常规的检索和语义匹配不同,对话数据中的问答匹配存在着丰富的场景信息,仅通过简单句对匹配,未必能够捕获到句子和句子之间的上下文关联信息。循环神经网络主要是捕捉序列之间的特征信息,因此根据我们的对话数据特点,设计并构建了一个基于双层循环神经网络的匹配模型。对于循环神经网络结构,在不断克服其缺点的过程中,衍生了很多变体,主要是对其循环单元提出了不同的计算方式。比较著名的有长短期记忆网络(long short term memory,LSTM)和门限循环单元(gated recurrent unit,GRU)。相对于长短期记忆网络,GRU具有与之相对的实验效果,同时运算参数更加简洁,计算速度更快。因此,最终选择了GRU作为模型循环计算单元。由于句子的词与词之间和同一组对话的句子与句子之间均存在着丰富的场景信息,因此构建了层级的循环神经网络分别对每个句子和句子组进行建模。模型基本结构如图7-8所示。其中q表示问句,a表示答句,当然q也可以表示答句,此时对应的a则表示问句,w表示对应句子中的字或词向量,h表示计算单元的输出状态。模型主要包括三个方面:基于GRU的句子建模,基于注意力模型的信息自动归纳以及答案置信度排序与阈值选择。

实验结果表明,在社区问答数据中,本案例中基于CNN的匹配模型优于RNN生成模型;在客服对话数据中,基于RNN的序列学习模型能够更好地学习到场景对话中的上下文信息。在基于每轮对话且问句完整的数据上,MAP达到了84.41%。针对交互式问答中连续语句之间存在的上下文相关联的潜在语义补充关系,本案例研究了句子补充关系的识别。在深度模型上,构建了并行CNN和串联LSTM对句子对进行抽象语义特征提取和建模。分别采用支持向量机、基于CNN的模型和基于RNN的模型,对句子对的补充关系进行分类。实验结果表明,基于CNN的识别方法优于其他对比方法,其F1值达到了67.8%。最终,将补充关系识别和匹配关系识别相结合应用于交互式问答语义匹配。

有关工业智能技术与应用的文章

目前有些地方还无法实现FTTH 的一步到位,这种情况下,交互式数字视频是一种较好的综合解决方案。如图11.20所示,主干系统采用共缆分纤的方式分别由FTTC传送双向数字信号,由HFC 传送单向模拟视频信号。图11.20SDV 结构原理图这种解决方案的优点是:可以充分利用现有HFC 有线电视网络,共享光缆、管孔等基础设施,兼容数字和模拟视频业务,并较好地解决FTTC 的供电问题。......

2023-06-26

因而,理解信贷资产证券化的功能,并以此为基础探析信贷资产证券化信用扩张的本质及其风险传导机制才能在明确我国现行信息披露问题的基础上,理解量化、敏感和全面的信息披露规则的逻辑根源。1.源于期限转换的期限错配资产证券化将短期债务组合转化为长期流动性工具与商业银行将储户的短期存款用作长期贷款类似。商业银行借短贷长也被称为期限转换。一项标准的资产证券化须按照非常严格的程序来完成。......

2023-07-17

由于半导体制造系统属于典型的Np-hard 问题, 传统的运筹学方法会带来繁杂的数据运算从而很难进行优化, 在实际应用中通常是寻求计算效率高、 优化效果较好的启发式算法, 本书给出求解该目标函数的一种启发式优化算法, 具体启发式算法流程图如图4-5 所示, 其步骤如下:Step 1: CCij信息初始化,t =0;Step 2: Dik需求招标值下达,wi 权重系数给定( i =1, 2, …......

2023-06-20

搅拌摩擦焊本身也存在如下缺点:1)不同的结构需要不同的工装夹具,设备的灵活性差。焊接速度 图2-4-21为焊接速度对铝锂合金搅拌摩擦焊接头抗拉强度的影响。......

2023-06-26

图6-7 无害化发泡生产工艺流程无害化发泡生产过程工艺有两个关键点,一是要将聚合物熔体与超临界流体充分混合并形成均相溶液;二是在成型的同时要使气体从聚合物熔体中析出形成尺寸小而均匀的大量气泡。......

2023-07-02

为降低或解决截断误差,国内外有些专家和学者提出了一些改善措施。设输入数据段长度为N1,系统响应长度为N2。全相位滤波法则是使用最大重叠的新方法,它考虑了对某个输入样本的所有长度为N的分段情况,如图1-7所示。图1-6 理想低通滤波器加矩形窗重叠法是由Malvar等人在DCT基础上提出的解决“方块效应”的方法。......

2023-06-23

外部感性负载在断电时,将通过电磁干扰的方式释放出大量的能量。为解决这个问题需根据驱动电路的形式和电源的类型,采取不同的措施,如图2-27~图2-29所示分别为直流感性负载和交流感性负载情况下的保护。借助二极管正向导通的特性,在感性负载两端并联二极管,可有效地消除瞬间高压。图2-29 交流感性负载情况下采用触点并联阻容电路消除触点间的电火花触点输出驱动的负载能量较大,既要正常工作又要消除高频电磁干扰是主要矛盾。......

2023-06-15

相关推荐