可靠性、抗干扰能力强是PLC最重要的特点之一。PLC采用扫描工作方式,减少了外界环境干扰引起故障的情况。这也是PLC获得普及和推广的主要原因之一。PLC的用户程序大部分可在实验室进行模拟调试,这缩短了应用设计和调试周期。PLC的应用领域目前在国内外,PLC已被广泛应用于冶金、石油、化工、建材、机械制造、电力、汽车、轻工、环保及文化娱乐等各行各业。随着PLC性价比的不断提高,其应用领域不断扩大。这是PLC最基本也是最广泛的应用。......

2025-09-29

卷积神经网络(convolutional neural networks,CNN)是对BP神经网络的改进,与BP一样,都采用了前向传播计算输出值,反向传播调整权重和偏置,CNN与普通神经网络的区别在于,CNN包含了一个由卷积层和子采样层(池化层)构成的特征抽取器。CNN相邻层之间的神经单元也并不是全连接,而是部分连接,某个神经单元的感知区域来自于上层的部分神经单元,而不是像BP那样与所有的上层神经单元相连接。

在CNN的一个卷积层中,通常包含若干个特征平面(feature map),每个特征平面由一些矩形排列的神经元组成,同一特征平面的神经元共享权值,这里共享的权值就是卷积核。卷积核一般以随机小数矩阵的形式初始化,在网络的训练过程中卷积核将学习得到合理的权值。

共享权值(卷积核)带来的直接好处是减少网络各层之间的连接,同时又降低了过拟合的风险。子采样也叫做池化(pooling),通常有均值子采样(mean pooling)和最大值子采样(max pooling)两种形式。子采样(池化)可以看作一种特殊的卷积过程。卷积和子采样大大简化了模型复杂度,减少了模型的参数,提高了模型的泛化能力。

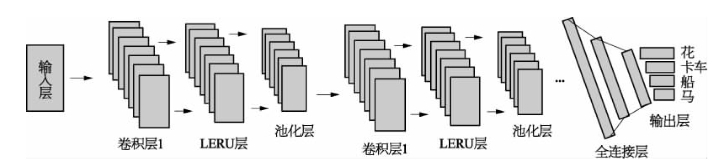

图7-5 卷积神经网络

一种典型的CNN网络,主要由输入层、卷积层、LERU层、池化层、全连接层以及输出层共六部分组成,如图7-5所示。卷积层是CNN的核心结构,通过局部感知和参数共享两个原理,实现了对高维输入数据降维处理,并且能够自动提取原始数据的优秀特征。激活层的作用与传统DNN网络的激活层一样,把上一层的线性输出,通过非线性的激活函数进行处理,既可以采用传统的sigmoid激活函数,也可以采用单侧抑制的ReLU激活函数。在深度学习领域,ReLU的单侧抑制激活函数普遍比传统的sigmoid函数效果更好。池化层也称为子采样层或下采样层,是CNN网络的另一个核心结构层。通过对输入数据的各个维度进行空间的采样,可以进一步降低数据规模,并且对输入数据具有线性转换的不变形,增强网络的泛化能力。全连接层等价于传统的多层感知机MLP,经过前面的卷积层和池化层的反复处理后,一方面,输入数据的维度已经下降至可以直接采用前馈网络来处理;另一方面,全连接层的输入特征是经过反复提炼的结果,因此比直接用原始数据作为输入所取得的效果更好。(https://www.chuimin.cn)

局部感受野是卷积核窗口在上一层图像上的映射,为了降低参数的维度以及防止过拟合出现,CNN中神经元并不是对上一层图像的全局进行感知,而是每个神经元只对卷积核窗口大小的局部区域进行感知,然后在更高层将局部的信息综合起来得到全局的信息。

CNN中每一层由多个特征图(map)组成,每个map由多个神经单元组成,同一个map所有的神经单元共用一个卷积核(即权重),卷积核跟上一层图像卷积往往得到图像的一个特征,权值共享策略减少了需要训练的参数,使得训练出来的模型的泛化能力更强。权值共享也实现了特征与位置的无关性,图像的一部分的统计特性与其他部分是一样的。意味着在这一部分学习的特征也能用在另一部分上,所以对于这个图像上的所有位置,都能使用同样的学习特征。每个卷积都代表了一种特征提取方式,就像一个筛子,将图像中符合条件(激活值越大越符合条件)的部分筛选出来。局部感受野其实是一个滤波的过程,也是一个对图像降维的过程。

一个卷积核代表了对图像上一个隐含特征的提取,为了充分理解和表达图像,需要使用多个卷积核,比如32个卷积核,可以提取并学习到32种图像的隐含特征。每个卷积核跟图像卷积后,生成另一幅图像,即特征图(feature map)。对输入图像的第一个卷积层,包含N个特征图像,不同特征图像是使用不同卷积核与原图像卷积的结果,每个卷积核代表了一种特征提取方式。

池化是对特征向量的下采样,进一步降低了特征的维度,减少了计算量,并且使训练不容易出现过拟合现象。池化也是一种滤波。

CNN的训练遵循“前向传输,逐层波浪式的传递输出值;逆向反馈,反向逐层调整权重和偏置”的规则,所不同的是,传统神经网络训练的目的是为了获取神经元间传递的权重和偏置,CNN训练的目的是为了获取神经元间卷积核的形式和偏置,即CNN中卷积层的权重更新过程本质是卷积核的更新过程。

相关文章

可靠性、抗干扰能力强是PLC最重要的特点之一。PLC采用扫描工作方式,减少了外界环境干扰引起故障的情况。这也是PLC获得普及和推广的主要原因之一。PLC的用户程序大部分可在实验室进行模拟调试,这缩短了应用设计和调试周期。PLC的应用领域目前在国内外,PLC已被广泛应用于冶金、石油、化工、建材、机械制造、电力、汽车、轻工、环保及文化娱乐等各行各业。随着PLC性价比的不断提高,其应用领域不断扩大。这是PLC最基本也是最广泛的应用。......

2025-09-29

在黄河调水调沙试验之前及其过程中,通过异重流实测资料分析,并结合试验成果,研究了异重流发生、运行及排沙等基本规律。在黄河调水调沙试验实施过程中,充分利用水库异重流运行规律及排沙特点,通过水库水沙联合调度,达到了减少水库淤积等多项预期目标。采用典型水库异重流流速分布资料对挟沙水流指数流速分布规律进行验证。图13-35异重流计算与实测含沙量比......

2025-09-29

光网络是面向传送的信息基础设施,在现代通信网中发挥着重要作用。与此同时,波分复用技术的成熟与广泛应用,为充分挖掘光纤带宽和支撑网络通信能力的增长提供了根本保证。下面重点讲述若干代表性光网络技术,包括光传送网、分组传送网、频谱灵活光网络等,它们分别从不同角度的发展思路和不同阶段的需求驱动,在宽带网络中发挥了重要作用。......

2025-09-29

云计算由分布式计算、并行处理、网格计算发展而来,是一种新兴的商业计算模型。目前,云计算仍然缺乏普遍一致的定义。云计算将IT相关的能力以服务的方式提供给用户,允许用户在不了解提供服务的技术、没有相关知识及设备操作能力的情况下,通过Internet获取需要的服务,具有高可靠性、高扩展性、高可用性、支持虚拟技术、廉价及服务多样性的特点。......

2025-09-29

图10.493颗同步卫星覆盖全球地球站1要与地球站3通信,由于地球站1、3不在同一颗星覆盖区内,因此必须通过卫星A、B覆盖的交叠区的地球站2进行中转。同步卫星通信系统的组成包括同步卫星、地球站和控制中心。图10.53星上处理转发器卫星电源分系统为了保证卫星的工作时间,必须有充足的能源,卫星上的能源主要来源于两部分:太阳能和蓄电池。......

2025-09-29

食品原料在世界范围内广泛种植并运输到加工企业。中国由于食品质量安全问题,在加入世界贸易组织后遭遇了前所未有的贸易壁垒。大米是中国在贸易自由化过程中唯一受益的粮食产品。随着农产品和食品质量安全法律法规体系逐步健全,大米安全追溯体系的研究与实施已经慢慢步入正轨,但仍存在些薄弱环节,有待今后深入研究。......

2025-09-29

异型材辅机除机头外,其他辅机基本与管材用配套辅机相同或类似。图4-12和图4-13所示是较复杂异型材真空定型模结构示意图,供广大读者设计时参考借鉴。控制盘上安装了控制整个异型材辅机运作的按钮开关和显示其运行状态的仪表。图4-15 多板式定型法1、2—金属 3—异型管材 4—定型模板组 5—冷却水槽 6—定型板支承柱 7—橡胶密封板5)滑动定型法主要用于开放或扁平的异型材。......

2025-09-29

RTLS由无线信号接收传感器和标签无线信号发射器等组成。RTLS通常建在一个建筑物内或室外识别和实时跟踪对象的位置。RTLS的物理层技术通常是某种形式的射频通信,但一些系统使用了光学或声技术代替了无线射频。目前,室内实时定位系统通常采用超声、红外、超宽带、窄频带等技术,在带宽、精度、墙体穿透性、抗干扰能力等方面存在各自的特点,其技术性能见表4-6。表4-6几种室内实时定位技术性能比较......

2025-09-29

相关推荐