1.什么是网络时空特征我生活的故事是不存在的。——玛格丽特·杜拉斯(法)成瘾现象的产生是网络使用者的个人特质与网络时空交互作用的结果。我们认为网络时空具有以下主要特征:开放性网络是一个开放的空间,被形容是一个低准入、无边界、无限扩张的城市,各种文化、思想都可以在这里交流、相汇和争鸣。通过以下的调查列表,可以看出网络已经成为了青少年的亲密伙伴和代言人。......

2023-12-04

深度信念网络(deep belief networks,DBNs)是一个概率生成模型,与传统的判别模型的神经网络相对,生成模型是建立一个观察数据和标签之间的联合分布,对P(Observation|Label)和P(Label|Observation)都做了评估,而判别模型仅仅评估了后者,也就是P(Label|Observation)。对于在深度神经网络应用传统的BP算法的时候,DBNs遇到了以下问题:

①需要为训练提供一个有标签的样本集;

②学习过程较慢;

③不适当的参数选择会导致学习收敛于局部最优解。

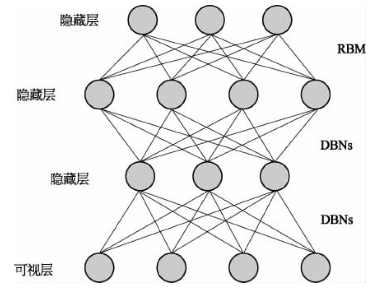

DBNs由多个RBM层组成,一个典型的神经网络类型如图7-4所示。这些网络被“限制”为一个可视层和一个隐层,层间存在连接,但层内的单元间不存在连接。隐层单元被训练去捕捉在可视层表现出来的高阶数据的相关性。

图7-4 深度信念网络拓扑图

首先,先不考虑最顶构成一个联想记忆(associative memory)的两层,一个DBNs的连接是通过自顶向下的生成权值来指导确定的,RBM就像一个建筑块一样,相比传统和深度分层的sigmoid信念网络,它能易于连接权值的学习。

最开始的时候,通过一个非监督贪婪逐层方法去预训练获得生成模型的权值,非监督贪婪逐层方法被Hinton证明是有效的,并被其称为对比分歧(contrastive divergence)。

在这个训练阶段,在可视层会产生一个向量v,通过它将值传递到隐层。反过来,可视层的输入会被随机的选择,以尝试去重构原始的输入信号。最后,这些新的可视的神经元激活单元将前向传递重构隐层激活单元,获得h。在训练过程中,首先将可视向量值映射给隐单元,然后可视单元由隐层单元重建,这些新可视单元再次映射给隐单元,这样就获取新的隐单元,执行这种反复步骤叫做吉布斯(Gibbs)采样。这些后退和前进的步骤就是我们熟悉的Gibbs采样,而隐层激活单元和可视层输入之间的相关性差别就作为权值更新的主要依据。

训练时间会显著减少,因为只需要单个步骤就可以接近最大似然学习。增加进网络的每一层都会改进训练数据的对数概率,这可以理解为越来越接近能量的真实表达。这个有意义的拓展和无标签数据的使用,是任何一个深度学习应用的决定性的因素。

在DBN框架最高两层,权值被连接到一起,这样更低层的输出将会提供一个参考的线索或者关联给顶层,这样顶层就会将其联系到它的记忆内容。最后得到的就是判别性能。

在预训练后,DBN可以通过利用带标签数据用BP算法去对判别性能做调整。在这里,一个标签集将被附加到顶层(推广联想记忆),通过一个自下向上的,学习到的识别权值获得一个网络的分类面。这个性能会比单纯的BP算法训练的网络好。这可以很直观地解释,DBNs的BP算法只需要对权值参数空间进行一个局部的搜索,这相比前向神经网络来说,训练是要快的,而且收敛的时间也少。

有关工业智能技术与应用的文章

1.什么是网络时空特征我生活的故事是不存在的。——玛格丽特·杜拉斯(法)成瘾现象的产生是网络使用者的个人特质与网络时空交互作用的结果。我们认为网络时空具有以下主要特征:开放性网络是一个开放的空间,被形容是一个低准入、无边界、无限扩张的城市,各种文化、思想都可以在这里交流、相汇和争鸣。通过以下的调查列表,可以看出网络已经成为了青少年的亲密伙伴和代言人。......

2023-12-04

2006年,Hinton提出了在非监督数据上建立多层神经网络的一个有效方法,简单来说可分为两步:一是每次训练一层网络,二是调优,使原始表示x向上生成的高级表示r和该高级表示r向下生成的x'尽可能一致。深度学习训练过程具体如下。......

2023-06-28

受索绪尔的影响,社会人类学家列维-斯特劳斯将结构主义的方法运用到社会分析中。当然,上述特征是结构主义研究的一个整体特点,并不是每项具体研究都具有的。在结构主义看来,结构如同一张巨网,人被局限于纵横交错的节点中,可以有些许位移,却无法永远逃脱。在中国城市的单位模式研究中,结构主义是总体的方法论基础,体现在研究的总体设计以及具体内容的分析等不同方面。......

2023-07-22

种种迹象表明,宣化辽墓饮茶与诵经壁画之间的联系,关系到死者的来世信仰。各棺箱普遍出现的经咒,有《阿閦如来灭轻重罪障陀罗尼》、《智炬如来心破地狱陀罗尼》、《大吉祥陀罗尼》、《佛说生天陀罗尼》、《转生净土陀罗尼》、《观音菩萨满愿陀罗尼》,此外还有专门以汉文书写的《般若波罗蜜多心经》。......

2023-07-22

以路飞为代表的海贼团成员,每个人都有着自己的梦想。路飞渴望成为海贼王,卓洛要成为世界第一的剑豪,娜美想要绘制出只属于自己的航海图,香吉士要去蓝海……有无数的人嘲笑他们的梦想,但是每一次,他们用勇气与毅力给予了回应,而赢得了他人的敬重。当视线被繁复的现状所迷惑,当梦想为现实的尘埃所埋没,事业便进入了山穷水复之中。因此,他成功地开拓了自己的事业。而这样的人,其事业也将会因梦想而有了超越平凡的可能性。......

2023-12-03

图5-14球与回转体相贯根据以上原理,可以用球面作辅助面求相贯线,此即辅助球面法。图5-15圆柱体与圆锥体相贯分析参与相贯的圆锥体、圆柱体都是回转体,它们的轴线相交且平行于正面,所以可以用辅助球面法求相贯线。作图确定辅助球面半径的范围。当然,由于难以控制辅助球面产生共有点的位置,相贯线上的某些特殊点不能准确求出,如本例中相贯线上的最左、最右两点的投影。......

2023-06-28

PaaS主要的用户是开发人员。数据安全问题 在应用管理方面,PaaS的安全原则就是确保用户数据只有用户本人才能访问和授权,实行多用户应用隔离,不能被非法访问和窃取。在这种环境下,PaaS层的数据安全问题主要来源于应用程序使用的静态数据是不加密的。......

2023-11-18

相关推荐