因为所收到的码字都是预先约定好的码字(许用码)。即再加一位重复码元,这样两个码字之间的差别有两位。增加的重复码元称为监督码元。如果将接通编为“111”,断开编为“000”,即有两位重复监督码元。条件概率按式(4-1)计算式中 CL——许用码字;ri——接收码字的第i位元素;CLi——许用码字CL的第i位元素。......

2023-06-27

如果把输出必须和输入相等的限制放松,同时利用线性代数中基的概念,即O=a1Ф1+a2Ф2+…+anФn,Фi是基,ai是系数,可以得到这样一个优化问题:

Min|I-O|

其中,I表示输入,O表示输出。

通过求解这个最优化式子,我们可以求得系数ai和基Фi,这些系数和基就是输入的另外一种近似表达。

因此,它们可以用来表达输入I,这个过程也是自动学习得到的。如果在上述式子上加上L1的Regularity限制,得到:

Min|I-O|+u(|a1|+|a2|+…+|an|)

这种方法被称为稀疏编码(sparse coding)。通俗地说,就是将一个信号表示为一组基的线性组合,而且要求只需要较少的几个基就可以将信号表示出来。“稀疏性”定义为:只有很少的几个非零元素或只有很少的几个远大于零的元素。要求系数ai是稀疏的意思就是说,对于一组输入向量,只想有尽可能少的几个系数远大于零。选择使用具有稀疏性的分量来表示输入数据是有原因的,因为绝大多数的感官数据,比如自然图像,可以被表示成少量基本元素的叠加,在图像中这些基本元素可以是面或者线。同时,比如与初级视觉皮层的类比过程也因此得到了提升,人脑有大量的神经元,但对于某些图像或者边缘只有很少的神经元兴奋,其他都处于抑制状态。

稀疏编码算法是一种无监督学习方法,它用来寻找一组“超完备”基向量来更高效地表示样本数据。虽然形如主成分分析(principal component analysis,PCA)技术能方便地找到一组“完备”基向量,但是这里想要做的是找到一组“超完备”基向量来表示输入向量,基向量的个数比输入向量的维数要大。超完备基的好处是它们能更有效地找出隐含在输入数据内部的结构与模式。然而,对于超完备基来说,系数ai不再由输入向量唯一确定。因此,在稀疏编码算法中,另加了一个评判标准“稀疏性”来解决因超完备而导致的退化(degeneracy)问题。

比如在图像特征提取的最底层要做边缘检测器的生成,那么这里的工作就是从原始图片中随机选取一些小块,通过这些小块生成能够描述他们的“基”,如图7-2右边的8×8=64个主成分组成的主成分,然后给定一个测试小块,可以按照上面的式子通过主成分的线性组合得到,而稀疏矩阵就是a,a中有64个维度,其中非零项只有3个,故称“稀疏”。

把底层作为边缘检测器,不同方向的边缘能够描述出整幅图像,所以不同方向的边缘自然就是图像的主成分了,而上上层又是上一层的组合主成分。

稀疏编码分为两个部分。

1)训练阶段:给定一系列的样本图片[x1,x2,…],需要学习得到一组基[Ф1,Ф2,…],也就是字典。

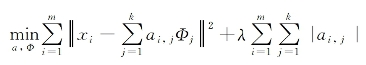

稀疏编码是k-means算法的变体,其训练过程也差不多,最大期望(expectation maximization,EM)算法的思想:如果要优化的目标函数包含两个变量,如L(W,B),那么可以先固定W,调整B使得L最小,然后再固定B,调整W使L最小,这样迭代交替,不断将L推向最小值。训练过程就是一个重复迭代的过程,按上面所说,交替的更改a和Ф使得下面这个目标函数最小。

每次迭代分两步:

①固定字典Ф[k],然后调整a[k],使得上式,即目标函数最小,即解最小绝对收缩和选择算法(least absolute shrinkage and selection operator,LASSO)问题。

②固定住a[k],调整Ф[k],使得上式即目标函数最小,即解凸二次规划(quadratic programming,QP)问题。

不断迭代,直至收敛。这样就可以得到一组可以良好表示这一系列x的基,也就是字典。

2)编码阶段:给定一个新的图片x,由上面得到的字典,通过解一个LASSO问题得到稀疏向量a。这个稀疏向量就是这个输入向量x的一个稀疏表达。

有关工业智能技术与应用的文章

因为所收到的码字都是预先约定好的码字(许用码)。即再加一位重复码元,这样两个码字之间的差别有两位。增加的重复码元称为监督码元。如果将接通编为“111”,断开编为“000”,即有两位重复监督码元。条件概率按式(4-1)计算式中 CL——许用码字;ri——接收码字的第i位元素;CLi——许用码字CL的第i位元素。......

2023-06-27

假设离散无记忆信源输出有限个符号xi,i=1,2,…离散信源编码就是对每个符号用一定长度的代码来表示。在信息论中已经证明,每个符号的二进制代码平均长度最短不应小于信源的熵。设信源共有L种符号,则需要的编码长度N 由log2L决定。当符号等概出现,但L不为2的整数次幂时,信源的平均信息量H与编码长度N 之间最多相差1bit。为了提高编码效率,对符号出现概率不相等的信源采用不等长编码。......

2023-06-27

基因的第1~6行分别表示目标编号、任务编号、无人机编号、无人机能力、目标价值和无人机对目标的攻击毁伤概率。如果一个(或多个)无人机均出现这种现象,就会出现无限等待导致“死锁”的情况。为了避免出现“死锁”,就将任务时序信息引入编码过程。由此,编码形成的染色体可以避免“死锁”的情况。......

2023-08-02

为寻找更为理想的基窗函数,借助LMS算法思想提出了“基于LMS准则以apSW为模型的基窗函数设计方法”。图3-21 余弦基神经自适应网络图3-21 余弦基神经自适应网络图3-22 apSW基窗LMS设计算法按照流程图,设计截止频率为π/4的32阶低通apSW的窗函数F。......

2023-06-23

机器学习一般根据处理的数据是否存在人为标注可分为监督学习和无监督学习。因此,监督学习的根本目标是训练机器学习的泛化能力。总之,机器学习就是计算机在算法的指导下,能够自动学习大量输入数据样本的数据结构和内在规律,给机器赋予一定的智慧,从而对新样本进行智能识别,甚至实现对未来的预测。机器学习的一般流程如图6-1所示。......

2023-06-28

即使不能说出准确的音名,也会指出错误。所以,督促孩子进行音乐练习是在孩子还没有独立学习能力之前要做的。演奏者将监督者作为榜样,以他们为目标成为更好的自己。......

2023-10-17

二维奇偶监督码不仅可以检测每行的奇数个错和每列的奇数个错,而且行列交叉可以检测每行和每列的偶数个错。此外,二维奇偶监督码的编码方式也具有较高的效率。图4-6二维奇偶监督码的图示表4-1垂直奇偶校验2.水平奇偶校验水平奇偶校验是将数据以适当的长度划分成组,然后对水平方向的码元进行偶监督,排列见表4-2。......

2023-06-27

图3-31 基于最小二乘的基窗F卷积窗C及滤波器特性实现上述结果的MATLAB代码如下:图3-31 基于最小二乘的基窗F卷积窗C及滤波器特性实现上述结果的MATLAB代码如下:卷积窗C性能参数B=0.2165,A=-14dB,D=-10.15dB。对比图3-16七种基窗可看出,利用最小二乘得到的基窗综合性能最好。此外,基于此结果基窗F的滤波器具有最小的均方误差。......

2023-06-23

相关推荐