支持向量机是Vapnik及其合作者[130]根据结构风险最小化原则提出的一种在高维特征空间使用线性函数假设空间的学习系统。支持向量机是机器学习领域若干标准技术的集大成者。在若干挑战性的应用中,获得了目前为止最好的性能。,xn)′标记为正类,否则,将其标记为负类。图3-4 二维训练集的分开超平面(w,b)图3-5 最优超平面对于多个模式类的分类问题,输出域是Y={1,2,…......

2025-09-29

随着科学技术的飞速发展,以及计算机、互联网的日益普及,越来越多的复杂、非线性、高维度数据需要进行分析和处理,这无疑对传统的统计学方法提出了严峻的挑战。

从数据中发现知识是分析复杂数据、建立决策系统的基石,而模式分析和回归分析则是知识发现中的重要内容,也是处理许多其他问题的核心。支持向量机是机器学习中的一项新技术,是借助于最优化方法来解决机器学习问题的新工具,开始成为克服维数灾难和过学习等困难的强有力的手段。它在解决小样本、非线性及高维度模式识别中表现出许多优势,并能够推广应用到函数拟合等其他机器学习问题中。

传统统计学研究的内容是样本无穷大时的渐进理论,即当样本数据趋于无穷多时的统计性质,而实际问题中的样本数据往往是有限的。因此,假设样本数据无穷多,并依此为基础推导出的各种算法很难在样本数据有限时取得理想的应用效果。当样本数据有限时,本来具有良好学习能力的学习机器有可能表现出很差的泛化能力。

支持向量机方法建立在统计学理论的VC维理论和结构风险最小原理基础之上,根据有限样本在模型的复杂性和学习能力之间寻求最佳折中,以期获得最好的推广能力。其中,模型的复杂性指对特定训练样本的学习精度,学习能力是指无错误地识别任意样本的能力。

支持向量机的定义是,根据给定的训练集:

T={(x1,y1),(x2,y2),…,(xl,yl)}∈(X×Y)l

其中,xi∈X=Rn,X称为输入空间,输入空间中的每一个点xi由n个属性特征组成,yi∈Y={-1,1},i=1,…,l。寻找Rn上的一个实值函数g(x),以便用分类函数:

f(x)=sgn(g(x))

推断任意一个模式x相对应的y的值的问题为分类问题。

在介绍结构风险最小(structural riskminimization)原理之前,首先对机器学习的本质做简要介绍。

机器学习本质上就是一种对所研究问题真实模型的逼近,通常会假设一个近似模型,然后根据适当的原理将这个近似模型不断逼近真实模型。毫无疑问的是,真实模型一定是不知道的,所以所选择的近似模型与真实模型之间究竟有多大的差距也就无从得知了,这也就引进了结构风险最小原理。

这个近似模型与真实模型之间的误差,通常称之为风险。在选择出一个近似模型之后,由于真实模型的未知性,所以真实误差也就无从得知,但是可以用某些可以掌握的量来逼近它。最直观的想法就是使用分类器在样本数据上的分类结果与真实结果之间的差值来表示,这个差值统计上称之为经验风险Remp(W)。

在过去的机器学习方法中,通常将经验风险最小化作为努力的目标,但是在实际的使用过程中却看到了这一方法的不足。通常很多分类函数能够在样本集上轻易达到百分之百的正确率,但是在投入实际具体问题中后却是错误百出,即模型无推广能力。在出现上述问题后,大家不难发现,由于所取得的样本数相对于现实世界的总体来说是非常渺小的,经验风险最小化原则只在占很小比例的样本上做到没有误差,但不能保证在更大比例的实际总体上也没有误差,所以这便是使用经验风险最小化原则建立的模型无推广能力的原因。

统计学习因而引入了泛化误差界的概念。所谓泛化误差界是指真实风险应该由两部分内容刻画:一是经验风险,代表了分类器在给定样本上的误差;二是置信风险,代表了我们在多大程度上可以信任分类器在未知样本上分类的结果。

泛化误差界的公式表示如下:

R(W)≤Remp(W)+φ(n/h)

式中,R(W)是真实风险,Remp(W)是经验风险,φ(n/h)是置信风险。统计学习的目标从经验风险最小化变为了寻求经验风险与置信风险之和最小化,即结构风险最小化。

支持向量机正是这样一种努力最小化结构风险的算法。

在了解函数间隔及接下来将要介绍的几何间隔之前,首先应了解Logistic回归所使用的回归模型,通过对Logistic回归模型的相应替换,得到支持向量机模型,并讨论支持向量机模型中的函数间隔及几何间隔。

在支持向量机模型中使用的结果标签是y=-1和y=1,以此替换在Logistic回归中使用的y=0和y=1;同时将系数θ替换由W和b表示,即以前的θTx=θ0+θ1x1+θ2x2+…+θnxn(认为x0=1),替换θ0为b,后面的θ1x1+θ2x2+…+θnxn替换为w1x1+w2x2+…+wnxn(即wTx)。这样,让θTx=wTx+b,进一步hθ(x)=g(θTx)=g(wTx+b)。也就是说,除了y由y=0变为y=-1,只是标记不同外,与Logistic回归的形式化表示没有区别。

再明确一下假设函数:(https://www.chuimin.cn)

hθ,b(x)=g(wTx+b),令Z=wTx+b

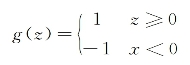

对于这个假设函数,我们只需要考虑θTx的正负问题,而不用关心g(z),因此这里将g(z)做一个简化,将其简单映射到y=-1和y=1上。映射关系如下:

给定一个训练样本(x(i),y(i)),x是特征变量,y是结果标签,i表示第i个样本。定义函数间隔如下:

![]()

刚刚定义的函数间隔是针对某一个样本的,现在定义全局样本函数间隔如下:

![]()

其中,i=1,…,m。

其实,对于函数间隔最直接的看法就是在训练样本上分类正例和负例确信度最小的那个函数间隔。

针对上述函数间隔的介绍,继续考虑W和b,如果同时加大W和b,比如在(WTx(i)+b)前面乘个系数,假设乘以2,那么所有点的函数间隔都会增大变为原来的两倍,这对求解问题是不会产生影响的,因为要求解的是WTx(i)+b=0,同时扩大W和b对结果是无影响的。这样,为了限制W和b,可能需要加入归一化条件,毕竟求解的目标是确定唯一一组W和b,而不是多组线性相关的向量。这个归一化的结果便是支持向量机的几何间隔。

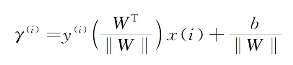

由此可以得到支持向量机几何间隔的定义如下:

由几何间隔的定义式可以看出,当‖W‖=1时,几何间隔便等于函数间隔。所以,无论W和b同时扩大多少倍,‖W‖都会跟随W和b同步扩大相同倍数,从而对结果无影响。所以可以定义全局的几何间隔为:

γ=min(γ(i))

其中,i=1,…,m。

之前讨论的情况都是建立在样例线性可分的假设上,当样例线性不可分时,可以尝试使用核函数来将特征映射到高维,这样很可能就可分了。正如图6-9中所示,原始特征是线性不可分的,但是通过对原始特征进行高斯变换后,得到的新特征就是线性可分的了,这便是对核函数最直接的理解。

图6-9 高斯核函数对数据的转换

所以可以将核函数形式化的定义为:如果原始特征内积是(x,z),映射后为[φ(x),φ(z)],那么核函数为:

K(x,z)=φ(x)Tφ(z)

相关文章

支持向量机是Vapnik及其合作者[130]根据结构风险最小化原则提出的一种在高维特征空间使用线性函数假设空间的学习系统。支持向量机是机器学习领域若干标准技术的集大成者。在若干挑战性的应用中,获得了目前为止最好的性能。,xn)′标记为正类,否则,将其标记为负类。图3-4 二维训练集的分开超平面(w,b)图3-5 最优超平面对于多个模式类的分类问题,输出域是Y={1,2,…......

2025-09-29

在TIG焊熔透控制系统中,控制器采用的是模糊PID控制方法,这种控制系统在焊接过程中具有自校正控制的功能。熔透控制是在起弧稳定后开始的,为了保证控制的准确性,取前10个周期的熔宽平均值作为整个控制过程的熔宽参考值。根据这些控制规则,再按照模糊控制推理合成规则进行运算,采用最大隶属度方法进行模糊判决,经过多次的试验和修改,得到最终的模糊控制表。......

2025-09-29

如果后件“C”只有类别值,自然可以想到使用此规则进行分类。典型的关联规则分类算法有CBA、CMAR和CPAR[99]。CBA是由Liu B等人提出的,是最早的也是最简单的关联规则分类算法[99]。在一些典型的分类数据集的测试中,CBA算法的实验精度高于C 4.5。但与CMAR不同的是,CPAR只选择每组中的“最好的”K个规则进行分类计算。可见,关联规则分类算法是一类基于规则的算法,其基础是频繁项目的与运算。......

2025-09-29

混沌粒子群优化算法的基本思想是采用混沌序列初始化粒子的位置和速度,先对当前粒子群体中的最优粒子进行混沌寻优,然后把混沌寻优的结果随机替换粒子群体中的一个粒子。,z1N),根据式(4-6)得到N个向量z1,z2,…如果粒子适应度优于全局极值gbest,则将gbest设置为新位置。则混沌粒子群优化算法的流程为:初始化,设置最大允许迭代次数或适应误差限,以及CPSO算法的参数惯性权值和学习因子。,PgD)进行混沌优化:将Pgi(i=1,2,…计算其适应值,得到性能最好的可行解pb。......

2025-09-29

在所有可能的项集中,有很多候选都不是频繁的。算法4.2Apriori算法伪代码FPGrowth方法使用一种增强的前缀树对数据D进行索引,以实现快速的支持度计算。FPGrowth将所有的项按照支持度的降序排列。FP树构建完成后,所有的频繁项集就可以从树中挖掘出来。基于频繁树模式的频繁集搜索方法见算法4.3。算法4.3FPGrowth算法伪代码......

2025-09-29

智力激励法是运用群体创造原理,充分发挥集体创造力来解决问题的一种创新设计方法。其中最常用的是书面集智法,即以笔代口的默写式智力激励法。函询集智法有两个特点,也是其优点。......

2025-09-29

在这个算法中,RSA问题被分解成两个子问题:路由子问题与频谱分配子问题。ES-RSA算法的伪代码如图8-3所示,当业务到达网络时,首先通过KSP算法找到k条最短路径,然后根据窃听概率分布计算出每条路径被窃听的概率,将路径窃听概率不满足高于业务需求MIRP值的路径删除,在路径选择结束后,利用首次适用算法进行频谱分配,由此得到资源分配结构。通过设置MIRP值条件可以有效地去除泄露概率较高的路径,由此降低被窃听的概率,实现安全性的提升。......

2025-09-29

利用MFVC在保障安全性与频谱效率方面的优势,人们提出了一种面向CIS的MES-RSA启发式算法。MES-RSA算法的伪代码如图8-6所示,其工作流程主要包括两步,第一步是分配路径资源,第二步是分配频谱资源。在路径资源的分配过程中,MES-RSA算法采用基于MFVC的安全策略响应到达的CIS业务的安全性需求。图8-6MES-RSA算法的伪代码在频谱资源分配部分,人们提出了多流频谱分配算法。首先,根据此限制条件删除无效频谱块,找出路径与子业务流相匹配的组合。......

2025-09-29

相关推荐