机器学习一般根据处理的数据是否存在人为标注可分为监督学习和无监督学习。因此,监督学习的根本目标是训练机器学习的泛化能力。总之,机器学习就是计算机在算法的指导下,能够自动学习大量输入数据样本的数据结构和内在规律,给机器赋予一定的智慧,从而对新样本进行智能识别,甚至实现对未来的预测。机器学习的一般流程如图6-1所示。......

2023-06-28

聚类分析是一种原理简单、应用广泛的机器学习技术。聚类分析就是把若干事物按照某种标准归为几个类别,其中较为相近的聚为一类,不那么相近的聚于不同类。

聚类分析在客户分类、文本分类、基因识别、空间数据处理、卫星图片分析、医疗图像自动检测等领域有着广泛的应用。聚类分析的研究是一个蓬勃发展的领域,数据挖掘、统计学、机器学习、空间数据库技术、生物学和市场学也推动了聚类分析研究的进展。聚类分析已成为机器学习研究中的一个热点。

聚类算法种类繁多,本节将选取普及性最广、最实用、最具有代表性的5种聚类算法进行介绍,其中包括:

●k-均值聚类(k-means);

●k-中心点聚类(k-medoids);

●密度聚类(densit-based spatial clustering of application with noise,DBSCAN);

●系谱聚类(hierarchical clustering,HC);

●期望最大化聚类(expectation maximization,EM)。

需要说明的是,这些算法本身无所谓优劣,最终运用于数据的效果却存在好坏差异,这在很大程度上取决于数据使用者对于算法的选择是否得当。本节我们将对这5种算法的基本原理和各自的特点进行简要介绍,并以图示方式辅助理解来指导算法选择。

(1)k-均值聚类

k-均值聚类算法是最早出现的聚类分析算法之一,它是一种快速聚类方法,但对于异常值或极值敏感,稳定性差,因此较适合处理分布集中的大样本数据集。

k-均值聚类的思路是以随机选取的A(预设类别数)个样本作为起始中心点,将其余样本归入相似度最高中心点所在的簇(cluster),再确立当前簇中样本坐标的均值为新的中心点,依次循环迭代下去,直至所有样本所属类别不再变动。算法的计算过程非常直观,图6-3所示为以将10个点聚为3类为例展示算法步骤。

图6-3 k-均值聚类算法步骤示例

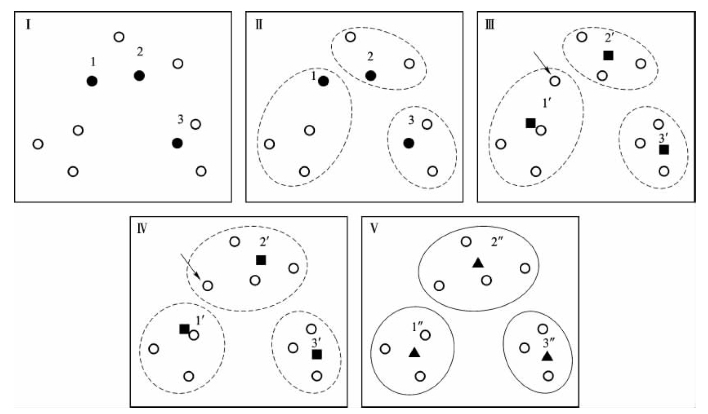

(2)k-中心点聚类

k-中心点算法与k-均值算法在原理上十分相近,它是针对k-均值算法易受极值影响这一缺点的改进算法。在原理上的差异在于选择各类别中心点时不取样本均值点,而在类别内选取到其余样本距离之和最小的样本为中心。

图6-4所示为该算法的基本运行步骤。

图6-4 k-中心点聚类算法步骤示例

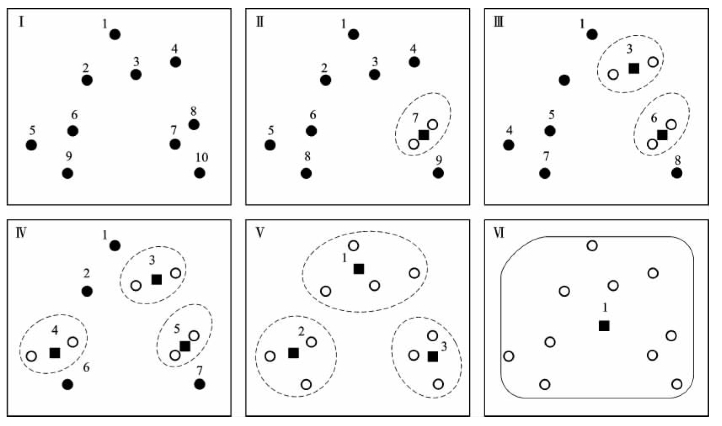

(3)系谱聚类

系谱聚类的过程可以通过类似于系谱图的形式呈现出来。相对于k-均值算法与k-中心点算法,系谱算法的突出特点在于不需事先设定类别数k,这是因为它每次迭代过程仅将距离最近的两个样本/族聚为一类,其运作过程将自然得到k=1至k=n(n为待分类样本总数)个类别的聚类结果,如图6-5所示。

图6-5 系谱聚类算法步骤示例

(4)密度聚类

密度聚类算法是基于密度的聚类方法中最常用的代表算法之一,另外还有OPTICS算法、DENCLUE算法等,读者可自行学习。

基于密度的聚类算法相对于如前所说的k-均值、k-中心点,以及系谱聚类这些基于距离的聚类算法,其优势在于弥补了它们只能发现“类圆形”聚类簇的缺陷,该类算法由于是基于“密度”来聚类的,可以在具有噪声的空间数据库中发现任意形状的簇。

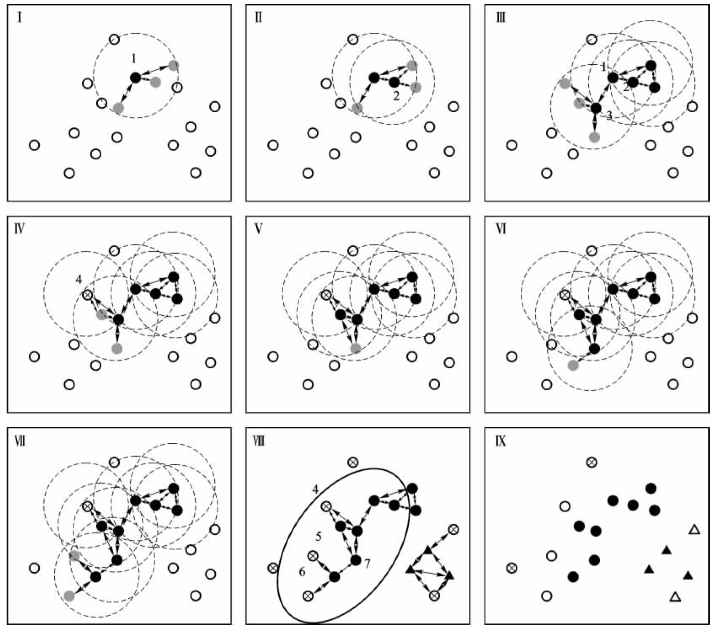

以密度聚类算法来详细说明,该方法将“簇”看作是数据空间中被低密度区域分割开的“稠密区域”,即密度相连样本点的最大集合。为了理解其思想,可参照图6-6来说明算法步骤,首先应明确其输入值为待聚类数据集、半径E(即为图中各圆形的半径大小)与密度阈值MinPts(图中取3),具体步骤如下:

①从数据集中选择一个未处理的样本点,如我们第一次选择图Ⅰ中的点1;

②以点1为圆心,作半径为E的圆,由于圆内圈入点的个数为3,满足密度阈值MinPts,因此称点1为核心对象(用黑色实心圆点表示),且将圈内的4个点形成一个簇,其中点1直接密度可达周围的3个灰色实心圆点;

图6-6 密度聚类算法步骤示例

③同理考察其他样本点,重复步骤②若干次,得到图Ⅲ,其中点1直接密度可达核心对象3,且点2密度可达点3;

④当该过程进行到图Ⅳ,我们发现点4的E邻域内仅有2个点,小于阈值MinPts,因此,点4为边缘点(非核心对象),暂标记为,然后继续考察其他点;

⑤当所有对象都被考察,该过程结束,得到图Ⅷ,看到椭圆形内有若干核心对象和边缘点,这些点都是密度相连的;

⑥最后一步即为将各点归类,见图Ⅸ,点集●相互密度可达,属于类别1,点集▲相互密度可达,属于新的一类,记类别2;点集○与类别1样本点密度相连,属于类别3;点集A与类别2样本点密度相连,属于类别4;点⊕即非核心对象,也不与其他样本点密度相连,为噪声点。

密度聚类算法的不足之处在于,它对于用户定义参数半径E及密度阈值MinPts很敏感,参数取值细微的不同可能会导致差别很大的结果,而且参数的选取无规律可循,只能不断尝试靠经验确定。

(5)期望最大化聚类

期望最大化算法的思路十分巧妙,在使用该算法进行聚类时,它将数据集看作一个含有隐性变量的概率模型,并以实现模型最优化,即获取与数据本身性质最契合的聚类方式为目的,通过“反复估计”模型参数找出最优解,同时给出相应的最优类别数而“反复估计”的过程即是期望最大化算法的精华所在,这一过程由E-step(expectation)和M-step(maximization)这两个步骤交替进行来实现。

该算法相比于前面介绍的几种聚类算法更为抽象,图6-7中,图Ⅱ是对图Ⅰ中的10个样本点随机聚类的初始结果,可以明显看到聚类效果很差;随后进行第一、二次迭代,聚类结果分别如图Ⅲ、图Ⅳ所示,每一次都比前一次更契合数据,至图V完成第三次迭代,聚类结束。

图6-7 期望最大化聚类算法步骤示例

有关工业智能技术与应用的文章

机器学习一般根据处理的数据是否存在人为标注可分为监督学习和无监督学习。因此,监督学习的根本目标是训练机器学习的泛化能力。总之,机器学习就是计算机在算法的指导下,能够自动学习大量输入数据样本的数据结构和内在规律,给机器赋予一定的智慧,从而对新样本进行智能识别,甚至实现对未来的预测。机器学习的一般流程如图6-1所示。......

2023-06-28

Hadoop可编写和运行分布式应用以及处理大规模数据,Mahout为一些机器学习算法框架库,但Mahout基于MapReduce计算框架,不适合处理迭代算法。因此,基于Spark和Hadoop框架结合的机器学习算法,要解决Mahout在应用迭代算法处理数据时消耗资源过多和系统整体性能下降的缺陷,提高数据处理分析的速度。基于MapReduce框架编写的Mahout机器学习库,使用HDFS技术在云基础架构上能够满足对大数据的存储要求,但I/O资源消耗过大造成系统整体性能降低[155]。......

2023-11-21

决策树是最经典的机器学习方法之一,它以树形结构将决策/分类过程展现出来,简单直观、解读性强,根据适用情况的不同,有时也被称为分类树或回归树。决策树呈现倒置的树形,即最上端为树的根,最下端为树的叶。机器学习中的决策树可以分为两个主要类型:分类树和回归树。[2000,3000]),则属于分类树范畴。虽然目前已有了在运行效率等方面进一步完善的算法C5.0,但由于C5.0多用于商业用途,C4.5仍是更为常用的决策树算法。......

2023-06-28

基于Spark+Hadoop处理技术的机器学习使得样本数量大量增加,以大量样本作为基础实现问题的分类求解。Spark不仅具有Hadoop MapReduce数据处理技术的优点,而且可以适用于需要迭代MapReduce算法的数据处理与机器学习等。通过大数据技术Spark+Hadoop进行全量数据分析,解决统计/机器学习依赖于数据抽样且不能精准反映全集的问题,揭示其全量数据分析而能精准反映全集的机理。......

2023-11-21

2.协作学习的形式在信息技术课程的教学中,我们可以通过以下模式进行协作学习:竞争。在任务完成过程中,协作者之间相互配合、相互帮助、相互促进,从而圆满完成学习任务。(三)学生在小组协作学习中的角色建构主义认为,学生是信息加工的主体,是意义的主动建构者,而不是外部刺激的被动接受者和灌输的对象。建构主义认为,教师应该成为实现学生知识意义建构的促进者、帮助者和指导者。......

2023-08-04

超前学习的挫败感会导致孩子产生“可得性愚笨”,这对其后继学业非常不利。但知识的准备并不是幼小衔接的重点或者全部。家长不能单纯引导幼儿识字,也不急于提前识字,更不能以识字量的多少来判断幼儿是否会阅读。到2002 年,学前班在农村作为幼儿教育的一种重要形式来发展,目前一些小学里还附属办有“学前班”,其目的是......

2023-07-19

Spark技术为基于内存的开源计算,Spark生态系统在机器学习领域的重要应用MLlib具有很多常用算法,实现了K-means等多种分布式机器学习算法。本章探讨Spark+Hadoop技术的机器学习的深度和广度提升了大数据分析的效率,适应迭代式机器学习模型的特定需求,分析数据中的关系以获得规律来预测新样本,对数据进行收集、统计和分析。......

2023-11-21

为提高机器学习模型的效用,我们采用5折交叉验证方法,随机从原始数据中选择10 000例,并均分成5个数据集,分别标记为1,2,…使用数据集训练机器学习模型时,每次随机选择其中一个数据集为测试集,其余4/5的数据作为训练集进行模型训练,从而建立模型。......

2023-07-31

相关推荐