Mean-Shift聚类是一个基于滑窗的算法,其目的是尝试找到数据点密集的区域。算法9.2M ean-Shift聚类确定滑动窗口半径r,以随机选取的中心点为C、半径为r的圆形滑动窗口开始滑动。Mean-Shift聚类的优点如下:不同于K-Means算法,均值漂移聚类算法不需要知道有多少类/组。基于密度的算法相比于K-Means受均值影响较小。Mean-Shift聚类的缺点:窗口半径r的选择可能是不重要的。......

2023-06-21

kNN算法最初由Cover和Hart于1968年提出的,是最近邻算法的一种推广,广泛应用于机器学习和数据分类。kNN算法是一种基于向量空间模型的预测性分类算法,通过计算向量之间的距离来确定待检测样本的类别。kNN算法的核心思想是:如果一个待检测样本在特征空间中的k个最相邻的样本中的大多数属于某一个类别,则该样本也属于这个类别,并具有这个类别上样本的特性。因此,kNN算法不具有显式学习的过程,而是利用样本集对向量空间进行划分。kNN算法原理如下。

输入:样本集

T={(x1,y1),(x2,y2),…,(xn,yn)}

其中,xi∈X⊆T为样本集的特征向量;

yi∈Y={c1,c2,…,cn}为样本的类别;

i=1,2,…,N;

X为待检测样本的特征向量。

输出:待检测样本所属类别y。

①根据选取的距离函数,在样本集T中找出与x最近距离的k个点,这k个点的邻域记作Nk(x);

②在Nk(x)中根据多数表决的判定规则,判断x的类别y;

式中I为指示函数,k为近邻个数,即当yi=cj时,I=1。

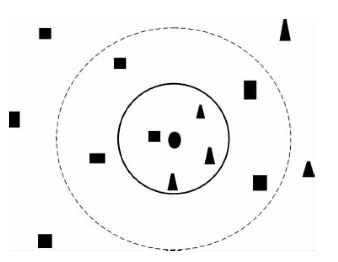

图6-2 k值选取分类效果

kNN算法中影响算法准确率的因素有距离函数和k值的选择,图6-2为选取不同k值分类的效果图。

样本集共两类:四方形和三角形,图中测试样本是圆形。运用kNN分类算法时,不同的k值影响分类结果:当k=1时,离其最近的一个样本是四方形,圆被判定为四方形一类;当k=4时,离其最近的四个样本中,三角形占3/4,圆被归为三角形一类;当k=8时,离其最近的8个样本中,四方形占5/8,圆被归为四方形一类。这就是对kNN分类原理的一个直观描述,也说明k值的选择直接影响分类的准确性。

kNN算法在处理大数据样本时是一种较好的分类算法,主要优点有:

①思路简单直观,方便实现,准确率高,传统的kNN算法无需对样本训练;

②没有过多的数据规则需要描述,分类过程直接利用样本与样本之间距离的关系,避免了其他因素对结果的影响,可以大幅减少误差,体现了分类规则独立性,特别适合类别特征不明显的分类问题;

③在执行分类的过程中只与少量的k个最相邻样本相关,特别适合多类别、大样本数据的分类计算。

kNN方法的不足之处主要有:

①对样本集依赖性较强,样本集中样本的多少以及样本类别的多少都会影响到kNN算法在实际的应用,由于在确定分类决策上只依据最邻近几个样本类别来决定待检测样本所属的类别,当样本不平衡,如一类样本容量很大,而其他类样本容量很小时,有可能导致造成不论k值多大,k个邻居样本大多数属于大容量类的,计算分类结果缺乏说服力;

②分类速度慢,kNN算法在进行分类计算时,是按照距离函数逐一计算待分类样本与样本集中的样本的距离,然后根据距离的大小进行分类,当样本的维数和规模比较大时,算法的复杂度较高,导致分类速度大幅度降低;

③k值的选择,由于kNN算法中几乎所有的计算都发生在分类阶段,而k值的大小直接关系到最终的分类准确率,一般情况下,k越大,分类的结果越准确;但是如果k值选择过大,且样本集较小时,会增加计算量,导致分类准确率下降;k值选择过小,得到的近邻数过少,也会降低分类精度;k值没有确定公式,一般通过人工取多个k值进行多次训练,取分类结果误差最小的k值。

有关工业智能技术与应用的文章

Mean-Shift聚类是一个基于滑窗的算法,其目的是尝试找到数据点密集的区域。算法9.2M ean-Shift聚类确定滑动窗口半径r,以随机选取的中心点为C、半径为r的圆形滑动窗口开始滑动。Mean-Shift聚类的优点如下:不同于K-Means算法,均值漂移聚类算法不需要知道有多少类/组。基于密度的算法相比于K-Means受均值影响较小。Mean-Shift聚类的缺点:窗口半径r的选择可能是不重要的。......

2023-06-21

萤火虫算法的核心思想是萤火虫被绝对亮度比它大的萤火虫所吸引,并根据位置更新公式更新自身的位置。考虑到萤火虫i的亮度随着距离的增加以及空气的吸收而减弱,可以定义萤火虫i对萤火虫j的相对亮度为:式(5.1)中,Ii为萤火虫i的绝对亮度,等于萤火虫i所处位置的目标函数值;γ为光吸收系数,可设为常数;rij为萤火虫i到萤火虫j的距离。γ为光吸收系数,表示吸引力的变化,它的值对萤火虫算法的收敛速度和优化效果有很大的影响。......

2023-11-26

机器学习一般根据处理的数据是否存在人为标注可分为监督学习和无监督学习。因此,监督学习的根本目标是训练机器学习的泛化能力。总之,机器学习就是计算机在算法的指导下,能够自动学习大量输入数据样本的数据结构和内在规律,给机器赋予一定的智慧,从而对新样本进行智能识别,甚至实现对未来的预测。机器学习的一般流程如图6-1所示。......

2023-06-28

从图4-2可以看出,利用CLBP算法从原始纹理图像中提取的三个分量图像,即符号分量图像CLBPS、幅值分量图像CLBPM和中心像素灰度等级分量图像CLBPC都含有重要的纹理特征信息,联合使用这三个分量图像所含有的特征信息将有助于进一步提高纹理图像的识别精度,这也是CLBP算法的纹理识别性能显著优于传统LBP算法的主要原因。图4-2利用CLBP算法提取纹理图像特征的结果......

2023-06-29

Stone对全隐式差分方程提出了新的迭代解法——强隐式迭代解法,简称SIP方法。由于这种迭代方法利用解方程组对全部格点同时加以改进,迭代效率非常高,已经十分接近直接解法,因而也就更加有效。Trescott等所做的比较研究表明:对于复杂的实际问题,SIP方法明显优于其他的迭代方法。表5-3-1ADI算法时间为500天时浓度场计算结果表5-3-2SIP算法时间为500天时浓度场计算结果图5-3-6SIP算法实例验证图算例2作者对三维SIP算法也进行了编程验证,作为......

2023-06-25

聚类分析发现强相关的对象组,而特异检测发现不与其他对象强相关的对象。图3.8K-means聚类方法与CpecuFind发现特异数据能力ROC曲线K-means聚类;CpecuFind表3.6K-means与CpecuFind发现特异数据能力ROC曲线面积对比上述对比说明,只简单地以簇类大小和对象与类心距离来评估对象的特异程度结果很粗糙,其评价特异数据的能力远不如Cpecu Find方法。......

2023-06-16

李汝珍对算法极为重视,书中三次谈到,显示了他的算学知识。也正因为对西洋诸国天然的排斥,所以李汝珍虽表彰才学技艺,却对与西洋国家很相像的智佳国不以为然。现在来看,李汝珍的这种态度不能不说是一件令人遗憾的事情。尽管李汝珍转而又否定了这个国度,但它毕竟存在着,是天朝人士应该学习的、可与”学问之国”黑齿国并称的”技艺之国”。......

2024-01-17

相关推荐