聚类分析发现强相关的对象组,而特异检测发现不与其他对象强相关的对象。图3.8K-means聚类方法与CpecuFind发现特异数据能力ROC曲线K-means聚类;CpecuFind表3.6K-means与CpecuFind发现特异数据能力ROC曲线面积对比上述对比说明,只简单地以簇类大小和对象与类心距离来评估对象的特异程度结果很粗糙,其评价特异数据的能力远不如Cpecu Find方法。......

2025-09-29

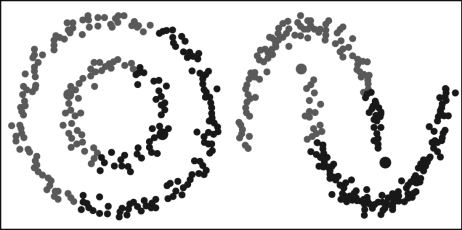

K-Means的一个主要缺点是它简单地使用了集群中心的平均值。如图9-4所示,可以看到为什么这不是最好的方式。图片的左半边,可以很明显地看到,有两个半径不同的圆形星团以相同的平均值为中心。K-Means不能处理这个问题,因为不同簇的平均值非常接近。当簇不是圆形时,K-Means也会失效,这也是将均值用作簇中心的后果。

图9-4 K-Means不适用的情况

高斯混合模型(Gaussian Mixture Models,GMM)具有比K-Means更好的灵活性。使用GMM,需要假设数据点是高斯分布,相对于环形的数据而言,这个假设的严格程度与均值相比弱很多。这样的话,有两个参数来描述簇的形状:均值和标准差。以二维为例,意味着簇可以是任何一种椭圆形(因为有两个标准差在x和y方向)。因此,每个高斯分布会被分配到单一的聚类簇。

为了在每个聚类簇中找到这两个高斯参数(均值和标准差),将使用的优化算法称为期望最大化(Expectation-Maximization,EM)算法。

算法9.4 EM算法(https://www.chuimin.cn)

(1)首先设定聚类簇的数量(如K-Means);然后随机初始化每个集群的高斯分布参数,也可以通过快速查看数据来为初始参数提供一个很好的猜测。

(2)给定每个簇的高斯分布,计算每个数据点属于特定簇的概率。一个点越靠近高斯中心,它就越可能属于该簇。这应该是直观的,因为对于高斯分布,假设大多数数据都靠近集群的中心。

(3)基于这些概率,我们为高斯分布计算了一组新的参数,这样就可以最大化集群中数据点的概率。使用数据点位置的加权和计算这些新参数,其中权重是属于特定集群的数据点的概率。

(4)重复第(2)步和第(3)步,直到收敛,也就是在收敛过程中迭代变化不大。

使用GMM有两个关键优势。首先,GMM在簇协方差方面比K-Means灵活得多;由于标准偏差参数的存在,簇可以呈现任何椭圆形状,而不局限于圆形。K-Means实际上是GMM的一个特例,其中每个簇的所有维的协方差都接近于0。然后,由于GMM使用概率,因此每个数据点可以有多个集群。因此,如果一个数据点位于两个重叠集群的中间,我们可以简单地定义它的类,方法是它属于类1的概率是X%,属于类2的概率是Y%,即GMM支持混合成员。

相关文章

聚类分析发现强相关的对象组,而特异检测发现不与其他对象强相关的对象。图3.8K-means聚类方法与CpecuFind发现特异数据能力ROC曲线K-means聚类;CpecuFind表3.6K-means与CpecuFind发现特异数据能力ROC曲线面积对比上述对比说明,只简单地以簇类大小和对象与类心距离来评估对象的特异程度结果很粗糙,其评价特异数据的能力远不如Cpecu Find方法。......

2025-09-29

图9-2DBSCAN基本概念(见彩插)图9-3“直接密度可达”和“密度可达”概念示意描述根据前面基本概念的描述知道:由于有标记的各点M、P、O和R的Eps近邻均包含三个以上的点,因此它们都是核对象;M是从P“直接密度可达”;而Q则是从M“直接密度可达”;基于上述结果,Q是从P“密度可达”;但P从Q无法“密度可达”(非对称)。......

2025-09-29

Mean-Shift聚类是一个基于滑窗的算法,其目的是尝试找到数据点密集的区域。算法9.2M ean-Shift聚类确定滑动窗口半径r,以随机选取的中心点为C、半径为r的圆形滑动窗口开始滑动。Mean-Shift聚类的优点如下:不同于K-Means算法,均值漂移聚类算法不需要知道有多少类/组。基于密度的算法相比于K-Means受均值影响较小。Mean-Shift聚类的缺点:窗口半径r的选择可能是不重要的。......

2025-09-29

算法9.1K-Means聚类选择一些类/组,并随机初始化它们各自的中心点,中心点是与每个数据点向量长度相同的位置。K-Means采用的启发式方式很简单,用下面一组图就可以形象地描述。图9-1K-Means的启发式方式(见彩插)......

2025-09-29

类弹丸活性聚能侵彻体化学能分布式释放过程如图3.3所示。爆轰波完全扫过活性药型罩后,罩体内压力及温度进一步升高,活性药型罩顶部发生明显形变,在轴线处发生翻转,形成类弹丸活性聚能侵彻体头部。基于以上假设,以侵彻体尾部端面中点为原点,建立二维平面物质坐标系,类弹丸活性聚能侵彻体化学能分布式释放计算模型如图3.4所示。在继续成形过程中,侵彻体中部及尾裙部分温度逐渐升高,相继发生激活。......

2025-09-29

与此同时,活性聚能侵彻体后部杵体形成,变形过程中温度继续升高,由于未到达激活弛豫时间,未发生反应。图3.2类射流活性聚能侵彻体化学能分布式释放计算模型根据类射流活性聚能侵彻体的形状,其可分为头部、中部及杵体3部分。式即类射流活性聚能侵彻体化学能随时间分布释放模型。在空间尺度上,类射流活性聚能侵彻体不断拉伸、运动。......

2025-09-29

图3.5类杆流活性聚能侵彻体化学能分布式释放过程虽然各微元速度梯度较类射流活性聚能侵彻体明显更小,但类杆流活性聚能侵彻体在运动及成形过程中不断拉伸延长,在t2时刻,长度为L2。在继续拉伸过程中,类杆流活性聚能侵彻体逐渐形成,整体密度降低,且由外至内、由头部至尾部,密度均逐渐下降。在空间尺度上,类射流活性聚能侵彻体不断拉伸、运动。......

2025-09-29

聚类的定义与待处理对象特征有关。聚类的方法很多,不同的方法对于同一数据集聚类的结果可能不同。根据层次分解形式的方式,层次聚类方法可划分为凝聚的层次聚类和分裂的层次聚类方法。绝大多数层次聚类方法属于这一类,它们的不同表现在簇内与簇间相似度的定义不同。目前,一般将基于层次的聚类方法和其他聚类技术进行集成以形成多阶段聚类,从而提高聚类质量。它是一种结构辅助聚类的方法,在大型数据库中的速度和伸缩性较好。......

2025-09-29

相关推荐