4)探查例外或特异数据。在数据集中,一些数据或对象与其中其他数据或对象显著不同,则称为特异数据或特异对象。在这些应用中,发现特异数据成为挖掘的目标。其中,基于统计的方法,主要是利用数据的分布特性计算特异数据的特征,采用不一致检验的方法挖掘数据。2)和3)的方法均从数据本身出发挖掘特异数据,本章将介绍基于密度的局部特异数据挖掘方法的思想和主要算法。......

2025-09-29

特异数据在整个数据集中占的比例很小,第3.1节的构架中有大量的冗余运算。设某一属性的所有值的数据集为S,其平均值为Smean。如果事先根据距离将S进行聚类,那么大类(其中数据个数多的类)中的数值成为特异的可能性就会很小,质心(类中数据的平均值)距Smean较近的类中的数值成为特异的可能性也会很小。第3.1节的构架精确地计算出了所有属性与记录的特异因子,而用户关心的只是特异值排序在前面的很少一部分属性与记录的特异因子值,对于排序在后面的特异因子值可以采用不精确的计算方法。根据这些想法,提出一种基于聚类的全局特异数据挖掘方法。

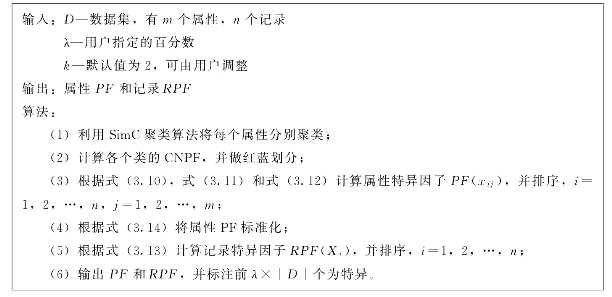

给定一个数据集D,D是由属性和记录组成的二维关系表。数据集的结构如表3.1所示。首先,一个百分数λ需要由用户给出。λ表示数据集D中特异数据占的比例,可以是用户预测D中有≤λ×|D|个特异数据或用户希望能找出前λ×|D|个特异值。另外,还需要设置一个聚类系数k,其值为2或3或4,可由用户指定,默认k=2。k的意义将在后面说明。构架仍由挖掘特异属性和挖掘特异记录两个层次构成。

在属性层次,首先,将每个属性按距离进行聚类;之后,计算每个属性聚类的反特异因子,并将属性聚类分成可能成为特异的类和不可能成为特异的类;最后,计算属性的特异因子并排序,指定前λ×|D|属性为特异的。

设某一属性的所有值的集合为S,其平均值为Smean。从原则上讲可以采用任何基于距离的聚类算法对S进行聚类,采用的聚类算法的效果好,可以减少后续的计算量。为了时间效率,使用的是一种类似于Squeezer算法[111]和文献[112]中聚类算法的简单聚类算法,称SimC(Simple Cluster),如图3.2所示。SimC算法思想简单,运行效率高。虽然聚类的结果并不优秀,但后面的实验将证明,SimC有效地支持了本章的构架。

图3.2 SimC聚类算法

可以看出,k是控制聚类半径Cd的。k越大,Cd越小,产生的类越多,同时每个类更精细。设S经聚类生成{C1,C2,…,Cη}η个类。现在根据式(3.9)计算每个类的特异因子,记为CPF(Cj)。式中,|Cj|表示类Cj中元素的个数。

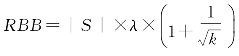

显然,CPF越小的类,其中的元素是特异数据的可能性越小。将η个类按CPF由大到小的顺序排序,设排序后的顺序为:C1′,C2′,…,Cη′。再设置一个阈值,称红蓝界RBB,并且 ,k是之前设定的聚类系数。从C1′开始累计类中元素个数,设当累计到Cjr′时结果第1次大于或等于RBB,则称C1′,C2′,…,Cjr′为红类;Cjr+1′,Cjr+2′,…,Cη′为蓝类。

,k是之前设定的聚类系数。从C1′开始累计类中元素个数,设当累计到Cjr′时结果第1次大于或等于RBB,则称C1′,C2′,…,Cjr′为红类;Cjr+1′,Cjr+2′,…,Cη′为蓝类。

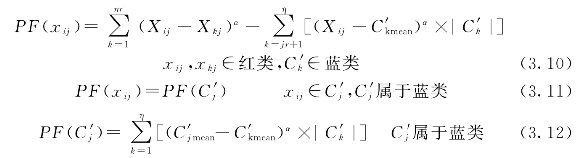

计算每个属性的特异因子PF时,红类中的元素将作为单个的值参加运算,也会有自己的PF值,蓝类将整个类参加运算,类中的元素共用一个PF值。设经聚类和分类后,类的序列为:C1′,C2′,…,Cjr′,Cjr+1′,Cjr+2′,…,Cη′,且红类为前jr个,所有红类中元素总个数的和为nr,属性PF值新的计算方法如式(3.10)~式(3.12)。

(https://www.chuimin.cn)

(https://www.chuimin.cn)

由式(3.10)~式(3.12)可以计算出表3.1中全部属性的PF值。计算记录的RPF时,对式(3.3)稍作变动,变为式(3.13),从先横向再纵向变到先纵向再横向。因为有大批属蓝类的属性有相同的PF值,式(3.3)的计算就可大大简化。

从聚类开始,经过前面的计算,可以得到每个属性的PF值和每个记录的RPF值。与第3.1节的构架不同的是,这里不需要p和pr来判断属性和记录的特异性,因为用户指定了λ,所以将PF从大到小排序,RPF从大到小排序,分别指定前λ×|D|个为特异的即可。

对于二维关系表的属性a1,a2,…,am的处理,与第3.1节类似。如果aj是表的主键,它是用来标识记录的,不需要计算其PF值;如果aj是表的外键,那么它是另一个表的主键,其PF值由那张表的RPF来确定;只有aj是表的一般属性时,才有必要计算其PF值。

对于不能区分等级的文本属性值,在聚类时可以简单地将具有相同值的聚为一类;计算类的CPF时,使用公式 ;计算两个值的距离时,按相同为0,不同为1的原则进行;计算属性PF时,只使用式(3.12)按类计算,其余的计算均可照常进行。

;计算两个值的距离时,按相同为0,不同为1的原则进行;计算属性PF时,只使用式(3.12)按类计算,其余的计算均可照常进行。

在使用式(3.13)计算整个记录的RPF(Xi)时,用户可以调节βj来控制各属性的权。为避免属性自身值的不平衡而给RPF造成的影响,计算RPF前应对属性的PF进行标准化(当然也可以采用将属性标准化的方法)。因为计算PF的标准差σ的时间复杂度是O(n2),可以采用式(3.14)来进行PF的标准化。其中,PFjmax和PFjmin分别是属性aj的PF值中的最大值和最小值。

根据新的构架,将特异计算过程总结为算法,称为CpecuFind算法,如图3.3所示。

图3.3 CpecuFind算法

相关文章

4)探查例外或特异数据。在数据集中,一些数据或对象与其中其他数据或对象显著不同,则称为特异数据或特异对象。在这些应用中,发现特异数据成为挖掘的目标。其中,基于统计的方法,主要是利用数据的分布特性计算特异数据的特征,采用不一致检验的方法挖掘数据。2)和3)的方法均从数据本身出发挖掘特异数据,本章将介绍基于密度的局部特异数据挖掘方法的思想和主要算法。......

2025-09-29

E.Knorr和R.Ng等在文献[109]中同时提出了一种基于网格构架的挖掘DB-outlier的方法。首先,全部的数据空间被分割成边长为l的网格。①如果Cx,y中的对象数>k,那么Cx,y中的所有对象均不是特异对象。M.M.Breuning等认为文献[106]中关注一个对象是否是特异的,而很多的应用中,给出一个对象的特异程度值更有意义。从[定义2.7]和[定义2.8]出发,M.M.Breuning等定义了一个度量对象p的特异程度的因子Local Outlier Factor,记为LOF[106]。......

2025-09-29

聚类的定义与待处理对象特征有关。聚类的方法很多,不同的方法对于同一数据集聚类的结果可能不同。根据层次分解形式的方式,层次聚类方法可划分为凝聚的层次聚类和分裂的层次聚类方法。绝大多数层次聚类方法属于这一类,它们的不同表现在簇内与簇间相似度的定义不同。目前,一般将基于层次的聚类方法和其他聚类技术进行集成以形成多阶段聚类,从而提高聚类质量。它是一种结构辅助聚类的方法,在大型数据库中的速度和伸缩性较好。......

2025-09-29

基于密度的局部特异数据挖掘方法的文献一般基于两个基本概念:k-distance和DB-outlier。显然,k-distance越大,p点附近的点密度越低,p的特异程度越高。从而确定了这类方法与统计方法的一致性。正态分布的特异定义DefNormal:p是特异的,当且仅当,此定义将正态分布中与均值距离不小于3的对象称为是特异的。说明了当参数μ=3时,泊松分布的特异数据界定。泊松分布的特异数据定义DefPoisson为:p是特异的,当且仅当,p≥8。......

2025-09-29

在借助数据结构存放中间结果来挖掘关联规则的算法中,FP-growth算法[89]效率较高,其中使用的树结构FP-Tree成为很多研究的基础。通过递归调用FP-growth的方法来直接产生频繁项目集。为方便后面叙述,表2.1中在第3列列出了每个事务中按降序排列的频繁项。第二次扫描数据库并构建FP-Tree。图2.6[例2.1]生成的FP-TreeFP-Tree的构造算法如图2.7所示。FP-growth算法以FP-Tree头表的倒序为计算顺序,从下至上递归搜索FP-Tree,逐步生成所有的频繁项集。图2.7FP-Tree的构造算法图2.8FP-growth算法......

2025-09-29

在所有可能的项集中,有很多候选都不是频繁的。算法4.2Apriori算法伪代码FPGrowth方法使用一种增强的前缀树对数据D进行索引,以实现快速的支持度计算。FPGrowth将所有的项按照支持度的降序排列。FP树构建完成后,所有的频繁项集就可以从树中挖掘出来。基于频繁树模式的频繁集搜索方法见算法4.3。算法4.3FPGrowth算法伪代码......

2025-09-29

数据挖掘就是综合应用一系列先进的技术从大量数据中提取人们感兴趣的信息和知识,它们是隐含的、事先未知且潜在有用的概念、规则、规律及模式等。这个概念诠释了数据挖掘的3个要点:数据挖掘要处理的数据量是巨大的。因此,高效率常常是数据挖掘算法研究的目标。4)数据转换:数据要被转换和整理,使其符合挖掘程序的格式。图2.1典型的数据挖掘系统构架......

2025-09-29

Apriori算法[3]是单维、单层、布尔关联规则挖掘算法,是最简单形式的关联规则挖掘。该算法是挖掘产生布尔关联规则频繁项目集的经典算法,对关联规则挖掘研究有着重要影响。图2.3Apriori-gen算法Apriori算法调用Apriori-gen,生成所有频繁项集,如图2.4所示。Apriori算法假定数据库驻留在内存中。Apriori算法之后,学者们不断研究其改进算法及其他思想的关联规则挖掘算法,取得了很多成果。图2.4Apriori算法图2.5找出频繁项集L后生成关联规则算法......

2025-09-29

相关推荐